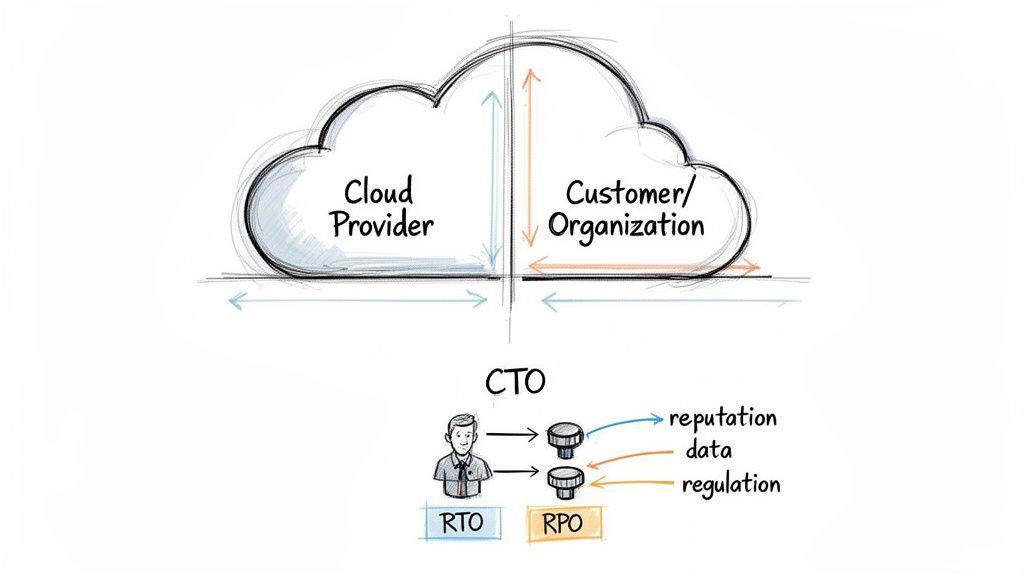

Il ripristino di emergenza nel cloud non riguarda semplicemente il backup dei dati. È la disciplina architettonica che garantisce che un’intera operazione digitale — applicazioni, infrastruttura e dati — possa essere ripristinata in modo prevedibile e affidabile dopo un guasto catastrofico. Questa responsabilità è condivisa: il provider cloud garantisce la propria infrastruttura, ma voi siete responsabili del recupero delle applicazioni e dei dati costruiti su di essa.

Questa guida fornisce un quadro pragmatico per CTO, architetti e responsabili dell’ingegneria per progettare, implementare e convalidare una strategia di ripristino di emergenza solida che si allinei con gli obiettivi aziendali e le realtà tecniche.

Ripensare il ripristino di emergenza come obbligo architetturale

Un’errata e pericolosa convinzione comune è che i provider cloud gestiscano il ripristino di emergenza end-to-end. Questa assunzione deriva da un malinteso del modello di responsabilità condivisa. Sebbene provider come AWS o Azure assicurino la resilienza della loro infrastruttura globale — data center, rete, hardware fisico — la vostra organizzazione è responsabile di tutto ciò che è costruito su quella base. Questo include le vostre applicazioni, i dati, le configurazioni e le policy di accesso.

Se una regione cloud va in errore o uno script di deployment difettoso corrompe un database critico, l’obbligo del provider è ripristinare i propri servizi. Non è loro responsabilità ripristinare la vostra specifica applicazione o recuperare i dati persi. Tale responsabilità ricade interamente sui vostri team di ingegneria e operations.

Da una checklist IT a un imperativo aziendale

Considerare il ripristino di emergenza come una semplice voce di conformità è una grave falla strategica. Per la leadership tecnica e di prodotto, la mancata implementazione di un piano DR solido si traduce direttamente in rischi aziendali severi:

- Danno reputazionale: Ogni minuto di downtime erode la fiducia dei clienti, difficile e costoso da recuperare.

- Perdita irreversibile di dati: Senza una strategia di recupero valida, dati critici aziendali e degli utenti possono andare persi in modo permanente.

- Sanzioni regolamentari: Quadri emergenti come DORA (Regolamento sulla resilienza operativa digitale) nel settore finanziario e la Direttiva NIS2 per le infrastrutture critiche impongono requisiti stringenti di resilienza, con multe sostanziali per la non conformità.

La realtà operativa è che il recupero è spesso incompleto. Statistiche recenti sul ripristino di emergenza mostrano che una percentuale significativa di organizzazioni non riesce a ottenere il pieno recupero dei dati dopo un incidente, rivelando un divario critico tra pianificazione ed esecuzione. Questo problema è particolarmente acuto per i dati SaaS, dove i tempi di recupero spesso sono molto al di sotto delle aspettative aziendali.

Definire gli obiettivi di ripristino come decisioni aziendali

Al centro di qualsiasi strategia di ripristino di emergenza efficace ci sono due metriche chiave. Non sono semplicemente parametri tecnici; sono decisioni aziendali fondamentali con dirette implicazioni architetturali.

Obiettivo del tempo di ripristino (RTO): Qual è la durata massima accettabile di indisponibilità del servizio prima che l’impatto aziendale diventi inaccettabile?

Obiettivo del punto di ripristino (RPO): Qual è il volume massimo di perdita di dati che l’azienda può tollerare, misurato in tempo dal momento del guasto?

Un RTO misurato in minuti richiede un’architettura altamente automatizzata e pre-provisionata, che è significativamente più costosa rispetto a una soluzione che supporta un RTO di 24 ore. Analogamente, un RPO vicino allo zero richiede la replica sincrona dei dati, una sfida ingegneristica non banale con considerevoli overhead di performance e costo. Questi obiettivi non sono interruttori da attivare o disattivare, ma riflettono direttamente la tolleranza dell’azienda per il downtime e la perdita di dati.

Questa guida illustrerà i pattern architetturali e le considerazioni implementative per costruire sistemi resilienti, efficaci ed economicamente sostenibili. Per contesto aggiuntivo, il nostro confronto tra infrastruttura cloud vs on-premise fornisce una panoramica di base.

Tradurre i bisogni aziendali in metriche ingegneristiche

Prima di progettare un’architettura di ripristino, è necessario tradurre i requisiti aziendali in obiettivi ingegneristici quantificabili. RTO (Obiettivo del tempo di ripristino) e RPO (Obiettivo del punto di ripristino) sono le metriche principali che determinano la complessità, l’architettura e il costo della vostra strategia DR.

RTO definisce il tempo massimo accettabile di inattività. RPO definisce la perdita massima di dati tollerabile. Le risposte a queste due domande — “Quanto tempo possiamo rimanere offline?” e “Quanti dati possiamo permetterci di perdere?” — guidano tutte le decisioni tecniche successive.

Obiettivo del tempo di ripristino (RTO) spiegato

RTO è il tempo target entro il quale un processo aziendale deve essere ripristinato dopo un disastro per evitare conseguenze inaccettabili legate alla interruzione della continuità operativa. Il conteggio del tempo inizia al momento del guasto e termina quando il servizio è pienamente operativo per gli utenti.

L’RTO riflette direttamente l’impatto aziendale. Un’API di pagamenti rivolta ai clienti può richiedere un RTO di minuti, poiché ogni secondo di inattività si traduce in ricavi persi e fiducia erosa. Al contrario, un sistema interno di elaborazione batch può tollerare un RTO di diverse ore senza causare una significativa interruzione aziendale.

Un RTO basso (minuti) impone ampia automazione e infrastrutture pre-allestite per il failover. Un RTO più alto (ore) può consentire un processo di recupero manuale ben documentato.

Obiettivo del punto di ripristino (RPO) spiegato

RPO definisce il periodo massimo tollerabile in cui i dati potrebbero andare persi a seguito di un grave incidente. È la differenza tra l’ultima copia coerente dei dati e il momento del guasto.

Un RPO di un’ora implica una perdita potenziale fino a un’ora di dati. Un RPO prossimo allo zero, che significa nessuna perdita di dati accettabile, richiede la replica sincrona dei dati — una soluzione tecnicamente complessa e costosa che impatta la latenza di scrittura.

Applicare RTO e RPO nella pratica

Non tutti i sistemi hanno la stessa importanza. Applicare obiettivi DR aggressivi in modo uniforme su tutte le applicazioni è un’allocazione inefficiente delle risorse. Un approccio più pragmatico è quello di classificare i servizi in tier in base alla loro criticità, definita in collaborazione con gli stakeholder aziendali.

Considerate questi due sistemi a confronto:

- Database delle transazioni e-commerce: In quanto sistema di registrazione degli ordini e dei pagamenti, è un servizio di primo livello. L’azienda richiederà un RTO e un RPO vicini allo zero. La perdita di dati è inaccettabile e il servizio deve essere ripristinato quasi istantaneamente per evitare perdite di ricavi. Questo requisito giustifica un’architettura attiva-attiva o di standby caldo.

- Cruscotto analitico: Questo sistema interno elabora i dati durante la notte. Può tollerare un RPO di 24 ore, poiché i dati vengono aggiornati quotidianamente. L’RTO potrebbe essere di diverse ore; la sua indisponibilità sarebbe un inconveniente ma non fermerebbe le operazioni core dell’azienda. Una strategia semplice di backup e ripristino è sufficiente ed economica.

Determinare RTO e RPO è un esercizio di gestione degli trade-off. Sebbene downtime e perdita di dati prossimi allo zero siano tecnicamente raggiungibili, il costo è spesso proibitivo. Chiarire questi obiettivi in anticipo garantisce che gli sforzi di ingegneria si concentrino sulla protezione di ciò che è più prezioso per l’azienda, producendo una strategia DR efficace e sostenibile.

Esplorare le architetture core per il ripristino di emergenza nel cloud

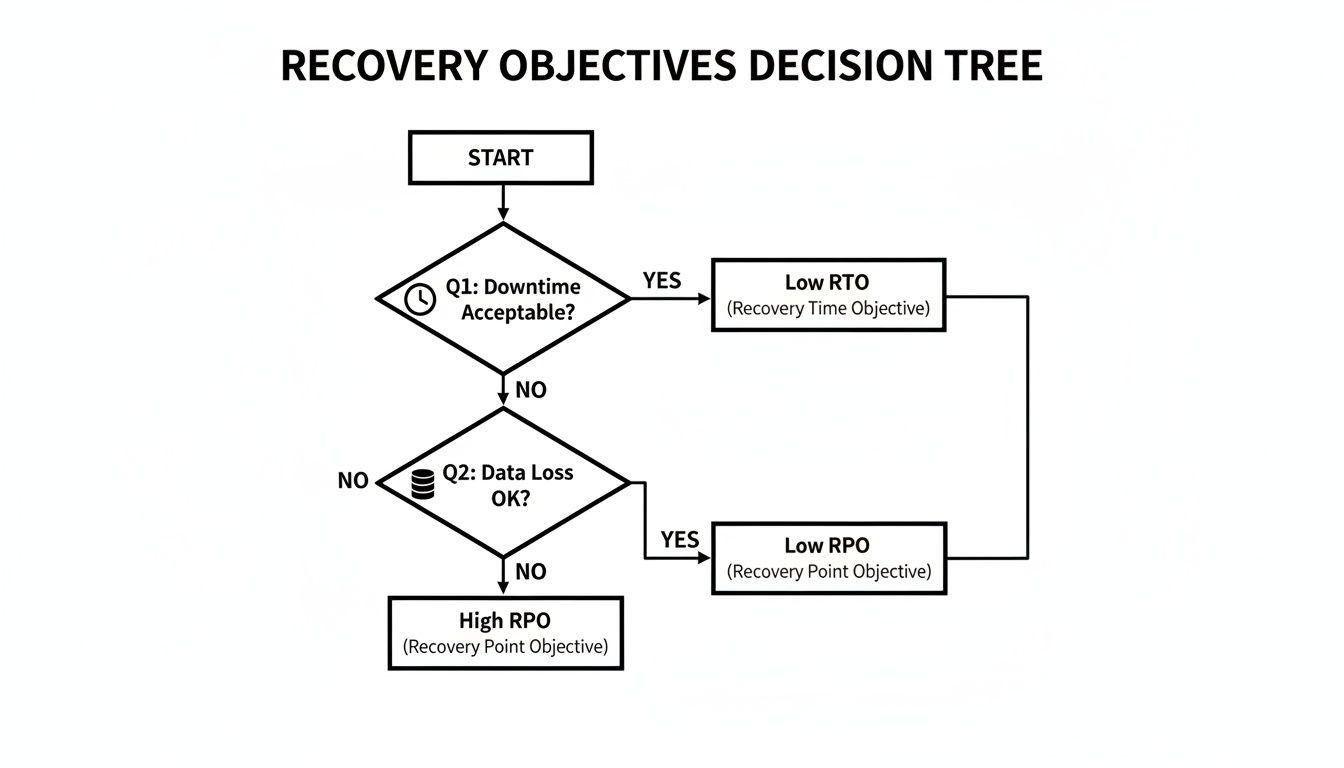

Con RTO e RPO definiti, il passo successivo è selezionare un pattern architetturale appropriato. Scegliere la strategia giusta per il ripristino di emergenza nel cloud richiede un bilanciamento tra velocità di recupero, tolleranza alla perdita di dati e complessità implementativa rispetto ai vincoli di budget.

Ogni approccio esiste su uno spettro di costo e performance. La scelta ottimale dipende dalla criticità dell’applicazione. Questo albero decisionale illustra come la tolleranza aziendale per downtime e perdita di dati mappi a specifiche scelte architetturali.

Come indica il diagramma, un’alta tolleranza al downtime permette strategie più semplici e a basso costo. Al contrario, sistemi critici per il business con bassa tolleranza alla discontinuità richiedono architetture più complesse e costose che garantiscano un recupero quasi istantaneo.

Esaminiamo i quattro pattern principali, dal più basilare al più resiliente.

Backup e Ripristino

Questa è l’architettura DR più fondamentale ed economica. Il principio è semplice: eseguire regolarmente il backup dei dati e delle configurazioni delle applicazioni in una posizione sicura e geograficamente separata (tipicamente un’altra regione cloud). In caso di disastro, viene provisioningata un’ambiente nuovo da zero e i dati vengono ripristinati da questi backup.

- Come funziona: Snapshot automatizzati di database, macchine virtuali e storage ad oggetti vengono creati a intervalli definiti. Durante un failover, ingegneri o script automatici provisioningano nuova infrastruttura e avviano il ripristino dei dati dall’ultimo backup disponibile.

- RTO/RPO tipici: L’RTO è misurato in ore o giorni, poiché implica il provisioning di nuove risorse e il ripristino di grandi volumi di dati. L’RPO è determinato dalla frequenza dei backup; backup giornalieri comportano un potenziale RPO fino a 24 ore.

- Adatto per: Sistemi non critici, ambienti di sviluppo/test e applicazioni interne dove tempi di inattività prolungati sono accettabili.

Il principale compromesso è il tempo. Pur essendo economica da gestire, la procedura di recupero è lenta e comporta il rischio più elevato di perdita di dati tra questi pattern.

Fiammella pilota

La strategia Fiammella pilota offre un equilibrio tra la lentezza del Backup e Ripristino e i costi più elevati di approcci più avanzati. Consiste nel mantenere una versione minima e ridotta dell’infrastruttura core nella regione di recupero. Questa “fiammella” è sempre accesa ma non gestisce il traffico di produzione.

L’analogia è quella di una caldaia a gas: la fiammella pilota è sempre accesa, pronta ad accendere i bruciatori principali quando necessario. In questa architettura, componenti essenziali come una piccola replica del database e un singolo server applicativo rimangono inattivi. Durante un disastro, l’infrastruttura viene scalata alla piena capacità di produzione.

Questo approccio riduce significativamente l’RTO rispetto al Backup e Ripristino perché l’infrastruttura core è già provisioningata. Il failover diventa un processo di scaling e di reindirizzamento del traffico, non di costruzione da zero.

- Come funziona: Un footprint minimo di infrastruttura, inclusa una replica del database, gira continuamente nella regione DR. I dati sono replicati in modo asincrono dalla regione primaria.

- RTO/RPO tipici: L’RTO è tipicamente da minuti a poche ore. L’RPO può essere di secondi o minuti, a seconda della latenza di replica dei dati.

- Adatto per: Applicazioni critiche per il business dove un RTO di diverse ore è inaccettabile, ma il costo di un ambiente completamente duplicato non è giustificato.

Standby caldo

Un’architettura Standby caldo estende il concetto di Fiammella pilota. Invece di un core minimo, viene mantenuta nella regione di recupero una versione completamente ridimensionata — ma inattiva — dell’ambiente di produzione. Il sistema è pronto a prendere il traffico quasi immediatamente.

Tutti i server, database e servizi sono in esecuzione e sincronizzati con l’ambiente di produzione ma non servono richieste utente. La differenza chiave rispetto alla Fiammella pilota è che durante il failover non è necessario effettuare scaling; l’infrastruttura viene semplicemente attivata. La sfida tecnica principale è mantenere la coerenza dei dati tramite replica continua. Il failover è spesso semplice come un cambio di DNS.

- Come funziona: Una copia completa e inattiva dell’ambiente di produzione viene eseguita in una regione separata con replica continua dei dati.

- Tipico RTO/RPO: RTO è ridotto a minuti. RPO è estremamente basso, spesso secondi.

- Ideale per: Servizi mission-critical, come piattaforme di e-commerce o applicazioni SaaS core, dove i tempi di inattività hanno un impatto finanziario diretto e significativo.

Multi-regione Attivo-Attivo

Questa è l’architettura di disaster recovery più resiliente—e la più complessa—offrendo downtime e perdita di dati praticamente nulli. In una configurazione Attivo-Attivo, l’applicazione viene eseguita simultaneamente in due o più regioni geografiche, con il traffico bilanciato tra di esse. Entrambi gli ambienti sono live e servono attivamente gli utenti.

Se una regione fallisce, il traffico viene automaticamente instradato verso la/e regione/i rimanente/i sana/e senza intervento manuale. Questa architettura elimina il concetto di “evento di failover”; un’interruzione regionale viene trattata come un evento operativo di routine. Tuttavia, questo livello di resilienza introduce notevole complessità ingegneristica e costi elevati.

- Sfide: Gestire la replica dei dati e la coerenza tra database distribuiti geograficamente è un ostacolo ingegneristico importante. Sono necessari networking complessi e instradamento del traffico per indirizzare gli utenti verso la regione sana più vicina mantenendo la località e la coerenza dei dati.

- Tipico RTO/RPO: Sia RTO che RPO sono praticamente nulli.

- Ideale per: Applicazioni globali con i requisiti di uptime più severi, come piattaforme di trading finanziario o servizi consumer su larga scala, dove qualsiasi periodo di inattività è inaccettabile.

Confronto tra architetture di disaster recovery cloud

Questa tabella fornisce un confronto affiancato per chiarire i compromessi tra le quattro strategie principali.

| Architettura | Tipico RTO | Tipico RPO | Costo relativo | Complessità di implementazione | Ideale per |

|---|---|---|---|---|---|

| Backup e ripristino | Ore a giorni | Minuti a 24 ore | Basso | Bassa | App non critiche, ambienti dev/test |

| Modalità pilota | Minuti a ore | Secondi a minuti | Medio | Medio | App business-critical con tolleranza moderata all’indisponibilità |

| Standby caldo | Minuti | Secondi | Alto | Alta | Servizi mission-critical con elevato impatto finanziario |

| Multi-regione Attivo-Attivo | Praticamente nullo | Praticamente nullo | Molto alto | Molto alto | App globali dove qualsiasi downtime è inaccettabile |

Come mostrato, esiste una correlazione diretta tra costo, complessità e prestazioni di ripristino. La chiave è allineare la scelta architetturale al valore di business dell’applicazione che protegge.

Sfruttare l’automazione per un ripristino affidabile

Un piano di disaster recovery manuale è un piano destinato a fallire. Durante un incidente reale, i livelli di stress sono elevati, gli ingegneri sono sotto enorme pressione e la probabilità di errore umano aumenta drasticamente. Fare affidamento su documentazione statica e checklist manuali è una ricetta per tempi di inattività prolungati e tentativi di ripristino falliti.

L’unica strada verso un ripristino prevedibile, rapido e affidabile passa attraverso automazione e orchestrazione. Trattando i processi di ripristino come codice, li trasformi da piani astratti in sistemi testabili e ripetibili.

Dai manuali statici al codice eseguibile

Il classico manuale di DR—un documento conservato in una wiki—spesso è obsoleto sin dalla sua creazione. I sistemi moderni evolvono troppo rapidamente perché la documentazione manuale resti accurata. La soluzione è codificare l’intero processo di ripristino.

Questo inizia con Infrastructure as Code (IaC). Strumenti come Terraform o AWS CloudFormation ti permettono di definire l’intero ambiente cloud—server, reti, gruppi di sicurezza, bilanciatori di carico—in file versionati. Questo consente di provisioningare un ambiente coerente e identico in una regione di ripristino con un singolo comando, eliminando il drift di configurazione e gli errori di setup manuale.

Un processo di ripristino automatizzato fornisce non solo velocità ma anche coerenza. Il codice viene eseguito in modo identico ogni volta, eliminando supposizioni e panico che compromettono gli sforzi manuali durante un blackout critico.

Questo approccio trasforma il tuo manuale operativo in un insieme di script eseguibili, integrando il DR nella tua strategia CI/CD. Puoi approfondire questa integrazione nella nostra guida su come costruire una solida pipeline CI/CD.

Automatizzare il failover e i controlli di integrità

Oltre al provisioning dell’infrastruttura, l’automazione è critica anche per il processo di failover in sé. Ogni passaggio manuale introduce un potenziale punto di guasto. Queste azioni dovrebbero essere scriptate e, dove possibile, automatizzate.

Aree chiave per l’automazione includono:

- DNS Failover: Servizi come AWS Route 53 o Azure Traffic Manager possono reindirizzare automaticamente il traffico verso una regione di ripristino sana basandosi su controlli di integrità configurabili. Questo è il meccanismo primario per reindirizzare il traffico di produzione con downtime minimo.

- Promozione del database: Gli script devono gestire la promozione di una replica in sola lettura nella regione di ripristino a nuovo primary/master. Questa è una procedura critica che deve essere orchestrata con precisione per prevenire la corruzione dei dati.

- Validazione post-failover: Una volta completato il failover, dovrebbero partire immediatamente controlli di integrità automatizzati per confermare che tutti i servizi siano operativi, connessi e stiano servendo correttamente il traffico prima che il ripristino sia dichiarato riuscito.

I rischi nascosti dei passaggi manuali

Anche con una solida strategia di automazione, le più grandi minacce spesso risiedono in interventi manuali non documentati eseguiti da ingegneri sotto pressione. Questi “rimedi eroici” durante un black-out raramente sono documentati e quasi mai ripetibili, creando un falso senso di sicurezza per incidenti successivi.

Molte organizzazioni restano impreparate. Una grande percentuale di aziende che utilizzano servizi cloud protegge meno della metà delle proprie applicazioni con un piano DR valido. Le principali sfide citate sono la complessità dei sistemi, le limitazioni del personale IT e la carenza di competenze.

Queste statistiche sottolineano la necessità dell’automazione. Integrando automazione e testabilità nella tua strategia di ripristino di emergenza nel cloud fin dall’inizio, passi da un approccio reattivo basato sulla speranza a una disciplina proattiva guidata dall’ingegneria che fornisce resilienza dimostrata.

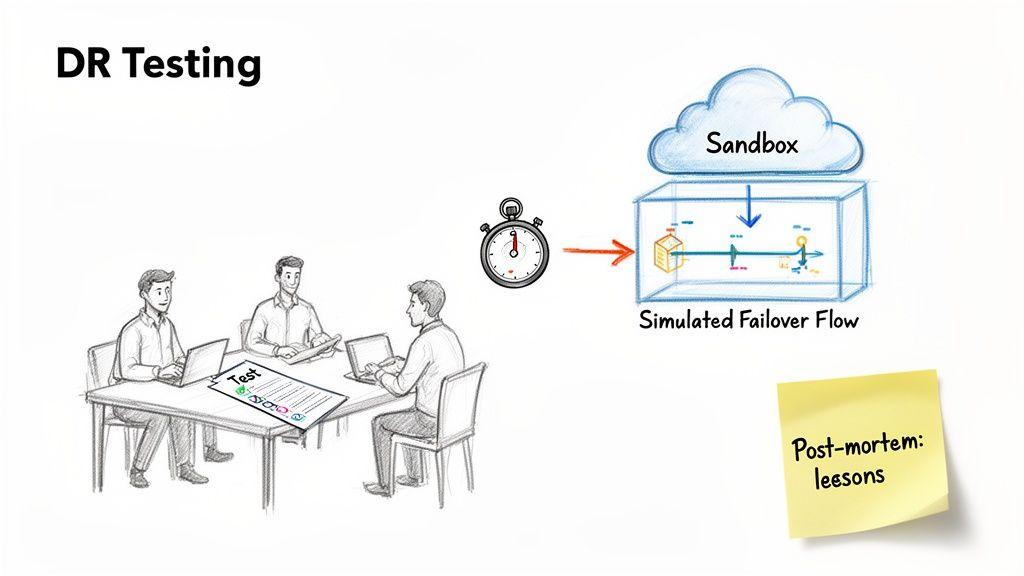

Validare il tuo piano di ripristino attraverso test rigorosi

Un piano di disaster recovery che esiste solo sulla carta è una responsabilità, non un asset. È un’ipotesi non testata sulla resilienza del tuo sistema. L’unico modo per convertire quell’ipotesi in una capacità affidabile è attraverso test regolari e rigorosi.

Senza validazione, non hai garanzie che gli script automatizzati si eseguano correttamente, che i backup dei dati siano validi o che il tuo team conosca i ruoli e le responsabilità durante una crisi. Per i responsabili compliance e prodotto, un piano non testato è una minaccia diretta alla posizione regolatoria e alla fiducia dei clienti. Funzionalmente, non è meglio che non avere alcun piano.

La posta in gioco finanziaria è enorme. I costi dei tempi di inattività possono variare da migliaia a milioni di dollari all’ora. Ancora più critico, un numero significativo di aziende che subiscono un grave disastro di dati senza un piano di ripristino testato non riesce a rimanere in attività. Come dettagliato in un’analisi sul ripristino di emergenza su Penncomp.com, i sistemi ad hoc non testati spesso conducono a restore lenti e backup corrotti.

Andare oltre il “teatro del ripristino di emergenza”

Una modalità di fallimento comune è il “teatro del ripristino di emergenza”—test superficiali che creano un falso senso di sicurezza. Questi esercizi, come il riavvio di un singolo servizio o un controllo di integrità dati di base, possono soddisfare un requisito di compliance ma non simulano i fallimenti a cascata di un vero disastro.

La validazione efficace richiede di spingere sistemi e team ai loro limiti operativi. Significa simulare guasti senza preavviso, testare dipendenze oscure e verificare che ogni passaggio del processo di ripristino funzioni come progettato. L’obiettivo non è superare un test, ma identificare e correggere attivamente le debolezze prima che un incidente reale le sfrutti.

Metodologie pratiche per test efficaci

Un approccio maturo al ripristino di emergenza nel cloud impiega una strategia di testing a più livelli. Invece di un unico grande test annuale, diversi tipi di test dovrebbero essere integrati nella tua cadenza operativa.

-

Esercitazioni al tavolo: Sono sessioni strutturate basate sulla discussione in cui il team di risposta percorre uno scenario di disastro simulato. L’obiettivo è convalidare la chiarezza del manuale operativo, identificare lacune nella comunicazione e assicurarsi che tutti i partecipanti comprendano i propri ruoli. È un metodo a basso rischio per testare gli elementi umani del piano.

-

Esercitazioni di failover parziale: In queste esercitazioni si simula il guasto di un servizio o componente specifico in un ambiente non di produzione. Ad esempio, effettuare il failover di una singola replica di database o di uno strato applicativo valida script di automazione e dipendenze tecniche specifiche senza mettere a rischio la disponibilità di produzione.

-

Simulazioni su vasta scala: Questo è il test più comprensivo, che prevede un failover completo dell’intero ambiente di produzione nella regione di ripristino. Pur essendo dirompente e dispendioso in termini di risorse, è l’unico modo per convalidare il processo di ripristino end-to-end in condizioni realistiche. Queste simulazioni sono essenziali per i sistemi mission-critical e devono essere pianificate con cura.

Un test riuscito è un test dal quale impari. Il post-mortem è la parte più preziosa dell’esercizio. Documenta ogni riscontro, aggiorna script di automazione e manuali operativi, e crea ticket per affrontare le debolezze identificate.

Una cultura di validazione continua è ciò che distingue le organizzazioni resilienti da quelle vulnerabili. Il testing non dovrebbe essere un evento annuale temuto, ma una pratica di routine che costruisce fiducia reale nella tua capacità di ripristinare.

Passare dalla pianificazione della resilienza alla realtà operativa

Il ripristino di emergenza nel cloud non è un progetto da completare ma una qualità architetturale fondamentale che deve essere mantenuta continuamente e allineata agli obiettivi di business. Un piano sulla carta è inutile durante un’interruzione reale; solo una capacità operativa provata può proteggere la tua organizzazione.

Il processo inizia traducendo i bisogni di business in vincoli ingegneristici attraverso metriche RTO e RPO ben definite. Questi obiettivi guidano la selezione di un’architettura appropriata—da un modello economico di Backup e ripristino fino a una configurazione Attivo-Attivo completamente resiliente—forzando compromessi espliciti tra costo, complessità e velocità di ripristino.

Abbracciare il miglioramento continuo

Tuttavia, un buon progetto è solo il punto di partenza. Senza automazione robusta e test rigorosi e regolari, anche i piani meglio concepiti degradano in teorie inaffidabili. L’automazione trasforma i manuali statici in codice eseguibile e ripetibile. Il testing convalida che sia i tuoi sistemi sia i tuoi team possono operare sotto pressione. Questo approccio sposta il DR da una configurazione una tantum a un ciclo di miglioramento continuo.

La vera resilienza non si ottiene scrivendo un piano; si costruisce con la convalida costante della tua capacità di ripristinare. Ogni test, sia esso un’esercitazione al tavolo o una simulazione completa, è un’opportunità per trovare e correggere le debolezze prima che un disastro reale lo faccia per te. L’obiettivo finale è andare oltre la semplice pianificazione e raggiungere uno stato di costante prontezza operativa. Questo approccio disciplinato, guidato dall’ingegneria, garantisce che i tuoi prodotti digitali rimangano disponibili e affidabili, proteggendo sia i tuoi clienti sia la tua azienda. Per i leader tecnici, promuovere questa cultura è una componente critica della salute del sistema e della manutenibilità a lungo termine, riecheggiando i principi del miglioramento continuo visti in come i progetti Kaizen mantengono i sistemi esistenti.

Domande frequenti

Risposte pragmatiche alle domande comuni di leader tecnici e aziendali riguardo i compromessi architetturali, i costi nascosti e le cadenzazioni realistiche dei test.

Come scegliere l’architettura di ripristino di emergenza più adatta?

Non esiste un’unica architettura “migliore”; la scelta è sempre un compromesso tra costo, complessità e i tuoi obiettivi di RTO/RPO. Un approccio a livelli basato sulla criticità delle applicazioni è la strategia più efficace e finanziariamente sensata.

Classifica i tuoi servizi:

- Sistemi critici: Questi includono servizi come gateway di pagamento o l’autenticazione utente principale, dove qualsiasi downtime impatta direttamente sui ricavi e sulla fiducia. Questi sistemi giustificano la spesa per un’architettura Warm Standby o Multi-Region Active-Active per raggiungere un RTO praticamente vicino allo zero.

- Applicazioni critiche per il business: Questi servizi sono essenziali per le operazioni ma possono tollerare brevi interruzioni. Un’architettura Pilot Light offre un equilibrio sensato tra velocità di ripristino e costo operativo per questo livello.

- Sistemi non essenziali: Strumenti interni, dashboard di analisi e ambienti di sviluppo raramente richiedono un ripristino immediato. Una strategia semplice e a basso costo di Backup and Restore è sufficiente.

Allineando l’investimento in resilienza con l’impatto sul business, puoi sviluppare un piano di ripristino di emergenza che sia sia efficace sia sostenibile.

Quali sono i principali costi nascosti?

I costi più significativi e spesso trascurati nel Disaster Recovery cloud sono operativi, non infrastrutturali. Mentre la bolletta mensile per risorse inattive è prevedibile, altre spese possono essere sostanziali.

Presta attenzione a queste tre aree:

- Onere ingegneristico: Le ore di ingegneria necessarie per creare, mantenere e testare script IaC, gestire la replica dei dati e mantenere aggiornati i runbook rappresentano un costo significativo e continuo. Questo carico di lavoro cresce man mano che i sistemi evolvono.

- Costi di uscita dei dati: Il failover in un’altra regione comporta il trasferimento di grandi volumi di dati attraverso la rete del provider cloud. Queste tariffe di uscita possono essere sostanziali e sono frequentemente omesse dai modelli di costo iniziali.

- Costo della complessità: Architetture altamente resilienti, in particolare Active-Active, introducono una complessità significativa. Gestire lo stato e garantire la coerenza dei dati tra regioni geograficamente distribuite crea costi ingegneristici e di manutenzione a lungo termine associati alla diagnosi e alla risoluzione di bug sottili nei sistemi distribuiti.

Quanto spesso dovremmo testare il nostro piano di ripristino di emergenza?

La frequenza dei test dovrebbe allinearsi al ritmo dei cambiamenti del sistema. Un’applicazione interna statica ha requisiti di test diversi rispetto a una piattaforma SaaS rivolta al cliente con deploy settimanali.

Per i sistemi critici, una cadenza ragionevole è eseguire esercitazioni di failover parziali su base trimestrale e una simulazione su larga scala annualmente. Questo ritmo costruisce fiducia operativa senza causare interruzioni eccessive.

Un approccio più avanzato integra la validazione del ripristino di emergenza (DR) nel ciclo di vita dello sviluppo. Qualsiasi modifica architetturale significativa — come la sostituzione di un database o l’introduzione di un nuovo microservizio — dovrebbe attivare un test di recupero mirato per il componente interessato. Questo trasforma il testing da evento annuale in pratica ingegneristica continua, garantendo che il tuo piano di ripristino rimanga sincronizzato con la realtà del sistema.

Una strategia robusta di ripristino di emergenza è una pietra angolare di qualsiasi prodotto digitale affidabile. In Devisia, aiutiamo le organizzazioni a progettare e costruire sistemi resilienti e manutenibili basati su scelte architetturali pragmatiche e obiettivi aziendali chiari. Scopri di più su come trasformiamo la visione in software affidabile su https://www.devisia.pro.