Privacy by Design non è un esercizio di conformità; è una disciplina ingegneristica per incorporare la protezione dei dati nell’architettura centrale di sistemi e prodotti. Considera la privacy come un requisito fondamentale, non una funzione opzionale aggiunta prima del deployment.

Il problema: la privacy come catalizzatore del debito tecnico

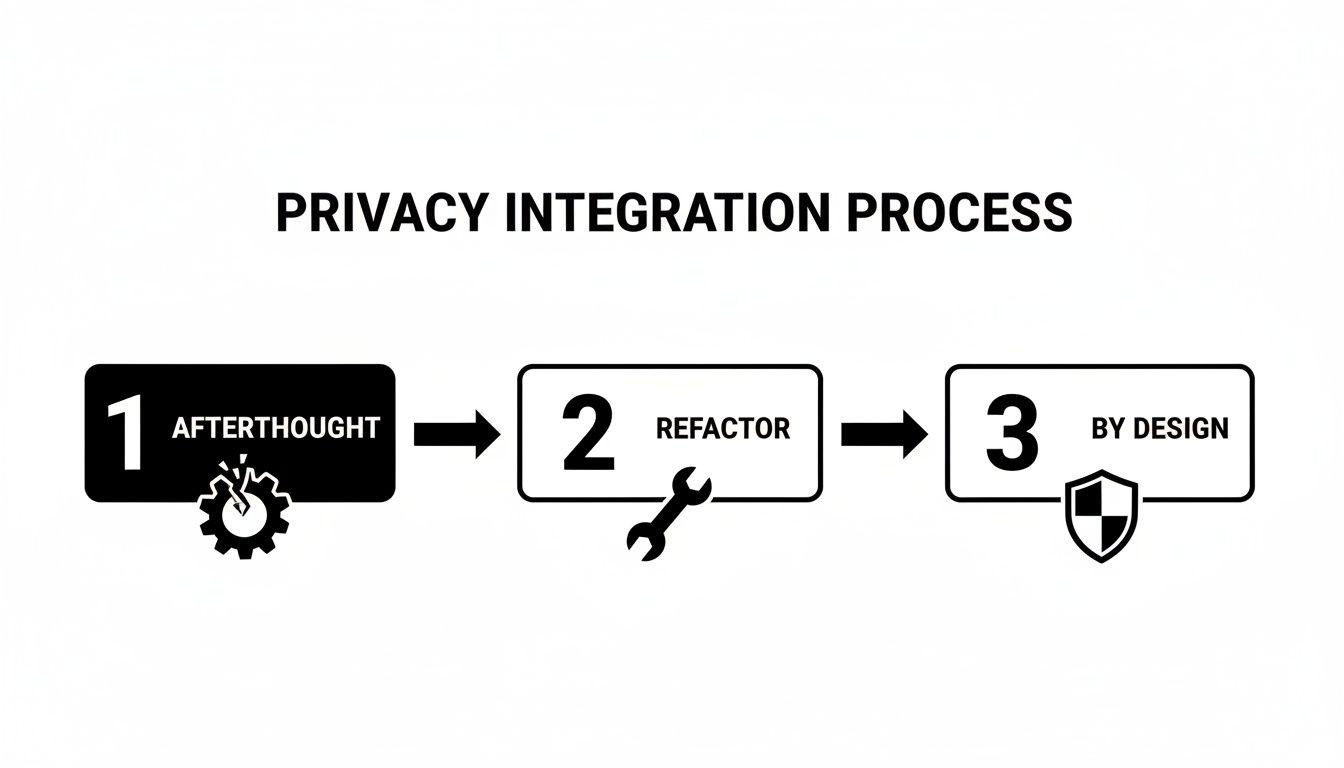

Per molti team di prodotto, la privacy viene affrontata come un ostacolo di conformità dell’ultima fase. Questo approccio reattivo è una delle principali fonti di debito tecnico. Quando la privacy è un ripensamento, i team di ingegneria sono costretti a costose rifattorizzazioni, integrazioni fragili e a una lotta perpetua per aggiungere nuove funzionalità senza violare le regole di gestione dei dati. È qui che emergono le vulnerabilità e si erode la fiducia degli utenti.

Adottare Privacy by Design inquadra diversamente la sfida. Sposta la protezione dei dati da un problema legale a un principio architetturale fondamentale. Il presupposto è semplice: una privacy robusta non può essere aggiunta in seguito; deve essere parte integrante del progetto del sistema fin dall’inizio.

Questa posizione proattiva genera significativi vantaggi architetturali e di business:

- Riduce il debito tecnico: Costruire i controlli di privacy fin dall’inizio evita i costosi e dirompenti lavori di rifacimento che affliggono i team reattivi.

- Migliora la resilienza del sistema: Un sistema progettato con la privacy come preoccupazione centrale è intrinsecamente più sicuro e robusto—è meglio ingegnerizzato.

- Costruisce fiducia nei clienti: Dimostrare un impegno nella protezione dei dati è un potente differenziatore di mercato che favorisce la fidelizzazione.

- Semplifica la manutenzione: Quando la gestione dei dati è intenzionale ed esplicita, l’intero sistema diventa più facile da comprendere, mantenere ed evolvere.

La giustificazione finanziaria per una privacy proattiva

Trattare la privacy come un’attività a bassa priorità ha conseguenze finanziarie tangibili. Il costo medio globale di una violazione dei dati ha raggiunto i $4.88 million per incidente.

È cruciale notare che le organizzazioni con programmi maturi di Privacy by Design risparmiano in media $1.5 million per violazione rispetto a quelle con pratiche immature. Questo rappresenta una riduzione dei costi del 31%. Da questa prospettiva, il PbD non è una spesa di conformità ma un investimento strategico nella resilienza finanziaria. Puoi trovare ulteriori approfondimenti su questi risparmi dei costi da violazione su standardfusion.com.

La privacy non riguarda la limitazione delle funzionalità; riguarda l’abilitazione della fiducia tramite una solida ingegneria. Un sistema che protegge i dati degli utenti per impostazione predefinita è un sistema ben progettato e resiliente, pronto per le sfide future.

I sette principi fondamentali

Il concetto di Privacy by Design si basa su sette principi fondamentali articolati dalla Dr.ssa Ann Cavoukian. Per ingegneri del software e architetti, questi non sono ideali astratti ma linee guida pratiche per la progettazione dei sistemi e i flussi di lavoro di sviluppo. Forniscono un quadro chiaro per costruire prodotti che rispettano gli utenti fin dall’inizio.

Trasformare i principi in pratiche ingegneristiche

| Principle | Core Concept | Practical Application in Software Development |

|---|---|---|

| 1. Proattivo, non reattivo; preventivo, non correttivo | Anticipare e prevenire i problemi di privacy prima che si verifichino. | Eseguire Valutazioni d’Impatto sulla Privacy (PIA) durante la fase di progettazione. Usare la modellazione delle minacce per i flussi di dati. |

| 2. Privacy come impostazione predefinita | Nessuna azione dell’utente è necessaria per proteggere la privacy; è integrata. | Le impostazioni predefinite per la condivisione dei dati sono “off.” La raccolta dei dati è minimizzata per impostazione predefinita. Usare l’opt-in per i trattamenti di dati non essenziali. |

| 3. Privacy integrata nella progettazione | La privacy è una componente fondamentale del sistema, non un’aggiunta. | Integrare i controlli di privacy direttamente nell’architettura dell’applicazione. La crittografia dei dati è una caratteristica nativa, non uno strato separato. |

| 4. Funzionalità completa—somma positiva, non somma zero | Accogliere tutti gli interessi legittimi senza falsi compromessi. | Progettare sistemi che offrano valore di business senza compromettere la privacy degli utenti. Rifiutare false dicotomie tra funzionalità e protezione dei dati. |

| 5. Sicurezza end-to-end—protezione del ciclo di vita completo | I dati sono protetti dalla raccolta alla distruzione. | Implementare la crittografia in transito e a riposo. Usare metodi sicuri di cancellazione dei dati. Applicare controlli di accesso rigorosi durante tutto il ciclo di vita dei dati. |

| 6. Visibilità e trasparenza—mantenerla aperta | Le parti interessate comprendono quali dati vengono raccolti e per quale scopo. | Fornire informative sulla privacy chiare e concise. Implementare cruscotti rivolti all’utente per gestire i dati personali e i consensi. |

| 7. Rispetto della privacy dell’utente—mantenere l’approccio incentrato sull’utente | L’architettura e la progettazione del sistema danno priorità agli interessi dell’utente. | Progettare flussi di consenso intuitivi e strumenti semplici per le richieste di accesso/cancellazione dei dati. Mettere l’utente al controllo dei propri dati. |

Questi principi stabiliscono che la privacy non è solo un’altra funzionalità nella backlog. È una metrica di qualità fondamentale per ogni sistema ben ingegnerizzato.

Integrare la privacy nel ciclo di vita dello sviluppo del software

Una Privacy by Design efficace non è una checklist occasionale ma una pratica continua integrata in ogni fase del ciclo di vita dello sviluppo del software (SDLC). Richiede un cambiamento culturale da una mentalità reattiva del tipo “risolvere dopo” a una disciplina ingegneristica proattiva in cui la privacy è una considerazione centrale.

Questo approccio trasforma principi astratti in abitudini concrete e quotidiane per il tuo team di ingegneria, spostando la privacy da un costoso ripensamento a un principio progettuale strategico.

Le organizzazioni mature non tamponano i buchi della privacy; costruiscono sistemi in cui la privacy è un componente integrante dell’architettura, con prodotti più resilienti e affidabili.

Scoperta e progettazione: la base critica

Questa fase iniziale è la più critica per implementare correttamente la Privacy by Design. Le decisioni prese qui hanno effetti a catena per tutto il progetto. Il costo per correggere un difetto di privacy in questa fase è di ordini di grandezza inferiore rispetto al tentativo di risolverlo dopo il lancio.

L’obiettivo primario è mappare come i dati personali scorreranno attraverso il sistema proposto. Le attività chiave includono:

- Valutazioni d’Impatto sulla Privacy (PIA): Una PIA è uno strumento strategico, non un esercizio di conformità. Condotta prima di scrivere codice, individua e mitiga i potenziali rischi per la privacy obbligando a chiarire quali dati vengono raccolti, perché sono necessari e come verranno protetti.

- Diagrammi di flusso dei dati (DFD): Queste mappe visive tracciano il ciclo di vita dei dati personali, mostrando dove vengono raccolti, elaborati, archiviati e condivisi con servizi di terze parti. I DFD rendono tangibili per l’intero team le regole astratte di gestione dei dati.

Ad esempio, un DFD per una nuova funzionalità di analisi illustrerebbe gli identificatori utente che transitano dall’applicazione client, attraverso un’API, verso un servizio di elaborazione e infine in un data warehouse. Questo evidenzia immediatamente potenziali vulnerabilità, come dati non criptati in transito o una conservazione eccessiva dei dati.

Sviluppo e architettura: implementare i controlli nel codice

Durante lo sviluppo, sono le decisioni architetturali a rendere concreta una postura di privacy. Il team di ingegneria traduce i requisiti della fase di progettazione in controlli robusti e automatizzati.

Le scelte tecnologiche sono critiche. Selezionare un database con crittografia a livello di colonna nativa o un provider di autenticazione con MFA integrata rafforza i controlli fin dall’inizio. L’architettura deve far rispettare principi come la minimizzazione dei dati.

Un anti-pattern comune è costruire sistemi che raccolgono un’ampia gamma di dati “per ogni evenienza”; questa pratica viola direttamente la minimizzazione dei dati e crea una superficie di rischio inutilmente ampia. L’architettura deve imporsi di raccogliere solo ciò che è strettamente necessario perché la funzionalità funzioni.

Test e QA: verificare le protezioni

I controlli di privacy devono essere testati con la stessa rigorosità di qualsiasi altra funzionalità. Il processo di QA deve includere casi di test specifici progettati per validare che le misure di privacy funzionino come previsto e siano resilienti sotto stress.

Il piano di test dovrebbe coprire scenari come:

- Revoca del consenso: Verificare che quando un utente revoca il consenso, i suoi dati vengano esclusi in modo programmatico dalle attività di elaborazione rilevanti, come campagne di marketing o modelli analitici.

- Richieste di cancellazione dei dati: Testare che una richiesta di cancellazione (Data Subject Access Request, DSAR) rimuova completamente i dati dell’utente da tutti i sistemi, inclusi database principali, cache, log e strumenti di terze parti.

- Validazione dei controlli di accesso: Scrivere test per confermare che un utente con un ruolo non possa accedere ai dati riservati ad un altro ruolo. Un utente standard può accedere a un endpoint admin? Un utente può visualizzare i dati privati di un altro utente?

Deployment e manutenzione: vigilanza continua

Gli obblighi di privacy non terminano al deployment. L’ultima fase del SDLC richiede vigilanza continua per assicurare che le protezioni rimangano efficaci mentre il sistema evolve e emergono nuove minacce.

Questo inizia con la gestione sicura della configurazione durante il deployment—cambiare le credenziali predefinite, chiudere porte inutilizzate e rinforzare gli ambienti di produzione. Una volta in produzione, la monitorizzazione continua è essenziale. Avvisi automatizzati dovrebbero notificare il team di potenziali incidenti di privacy, come pattern anomali di accesso ai dati o picchi di tentativi di login falliti.

Infine, un processo ben documentato per gestire le richieste dei soggetti interessati è fondamentale. Quando un utente richiede i propri dati o la loro cancellazione, il team deve avere un workflow chiaro per eseguire la richiesta accuratamente e nei tempi legali previsti. Questo processo deve essere regolarmente testato e raffinato.

Pattern architetturali per Privacy by Design

Passare dai principi all’implementazione richiede la selezione di pattern architetturali specifici. Queste sono decisioni ingegneristiche concrete che formano la base di un sistema privato e sicuro.

Mettere a punto questi pattern è ciò che separa un prodotto veramente resiliente da uno con una politica sulla privacy superficiale.

Esaminiamo i pattern core che abilitano la privacy by design, includendone i compromessi nel mondo reale.

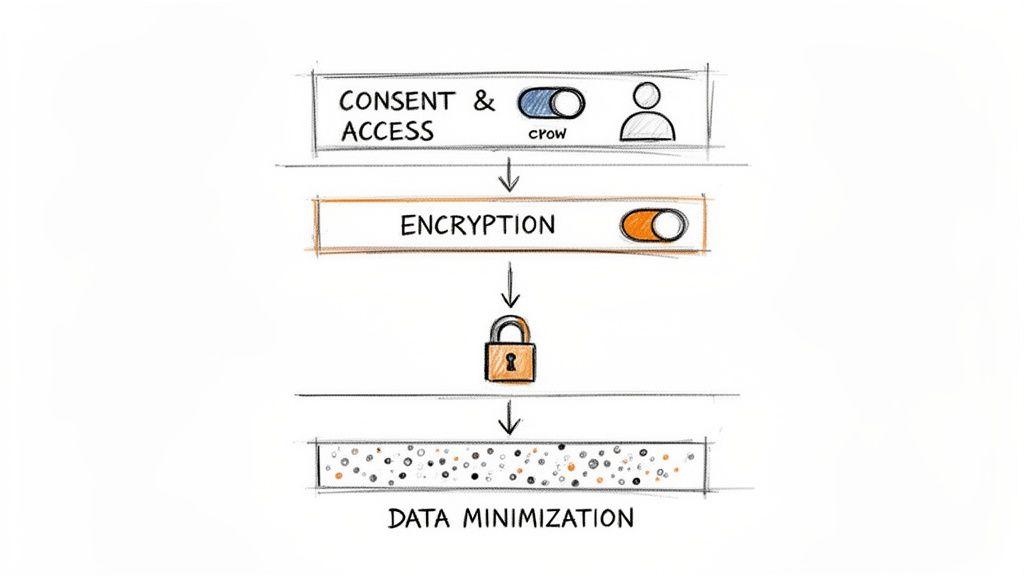

Minimizzazione dei dati e anonimizzazione

Il modo più efficace per proteggere i dati è non raccoglierli. La minimizzazione dei dati è una disciplina architetturale che richiede una giustificazione per ogni punto dati raccolto e archiviato. Contrasta direttamente la pratica ad alto rischio di raccogliere dati “per ogni evenienza”.

Quando la raccolta dei dati è necessaria, anonimizzazione e pseudonimizzazione sono controlli secondari critici. Rompono il collegamento tra i dati e un individuo, permettendo casi d’uso come l’analisi pur proteggendo la privacy.

- Pseudonimizzazione: Sostituisce identificatori diretti (es. nome, email) con un token costante ma artificiale. Questo permette di tracciare l’attività dell’utente senza esporre informazioni personali dirette. Il compromesso è la reversibilità: se la chiave di pseudonimizzazione viene compromessa, i dati possono essere ricollegati.

- Anonimizzazione: Rimuove o modifica i dati in modo irreversibile per rendere la re-identificazione computazionalmente impraticabile. Tecniche come il k-anonimato assicurano che un individuo sia indistinguibile da almeno k-1 altri, mentre la privacy differenziale aggiunge rumore statistico ai risultati delle query per proteggere i record individuali.

Il compromesso principale con l’anonimizzazione è tra l’utilità dei dati e la privacy. Anonimizzare eccessivamente può rendere i dati inutilizzabili per l’analisi; anonimizzare in modo insufficiente crea una falsa sensazione di sicurezza. La tecnica scelta deve allinearsi al profilo di rischio dei dati e all’uso previsto.

La ricerca indica che i sistemi costruiti con questi principi riportano fino al 60% in meno di violazioni dei dati. Uno studio di caso proveniente da un ospedale europeo ha mostrato una riduzione del 40% delle violazioni in due anni dopo aver integrato crittografia e anonimizzazione durante una riprogettazione del sistema. Questo dimostra che quando la privacy viene integrata è importante quanto come. Puoi consultare i risultati completi di questa ricerca sull’efficacia del design dei sistemi.

Confronto delle Tecniche di Anonimizzazione dei Dati

Scegliere la tecnica giusta di anonimizzazione o pseudonimizzazione richiede la comprensione dei suoi punti di forza, delle sue debolezze e dei casi d’uso appropriati. La seguente tabella confronta i metodi più comuni.

| Tecnica | Descrizione | Ideale per | Compromesso principale |

|---|---|---|---|

| Pseudonimizzazione | Sostituisce gli identificatori diretti con token o alias coerenti. | Tracciare i percorsi degli utenti o analisi longitudinali senza memorizzare direttamente i dati personali (PII). | Reversibile. Se la chiave di mapping viene compromessa, i dati possono essere ri-identificati. |

| Mascheramento dei dati | Oscura specifici campi dei dati sostituendoli con dati fittizi ma realistici. | Creare dataset di test o sviluppo realistici a partire dai dati di produzione. | Può essere complesso mantenere strutture e relazioni dei dati realistiche. |

| K-Anonimato | Garantisce che un individuo non possa essere distinto da almeno k-1 altri individui in un dataset. | Pubblicazione di dataset statistici o condivisione di dati con terze parti per la ricerca. | Può ridurre l’utilità dei dati, poiché alcuni record potrebbero dover essere soppressi o generalizzati. |

| Privacy differenziale | Aggiunge un “rumore” matematico ai risultati delle query per proteggere la privacy individuale. | Analisi su larga scala e machine learning dove la privacy individuale è fondamentale. | Il rumore aggiunto può influenzare la precisione delle query su dataset di dimensioni ridotte. |

Nessuna singola tecnica è una soluzione completa. Sistemi robusti spesso sovrappongono più approcci in base alla sensibilità dei dati e al loro uso previsto, con l’obiettivo di rendere la ri-identificazione praticamente impossibile preservando l’utilità necessaria dei dati.

Crittografia in transito e a riposo

La crittografia è un controllo fondamentale e non negoziabile. Garantisce che anche se i dati vengono intercettati o l’archiviazione è compromessa, le informazioni restino illeggibili senza le chiavi crittografiche appropriate. Questa protezione deve essere applicata universalmente.

Crittografia in transito protegge i dati mentre si spostano tra servizi, ad esempio dal browser di un utente al tuo server o tra microservizi interni.

- Best Practice: Applicare TLS moderno (Transport Layer Security), specificamente TLS 1.2 o superiore, su tutti gli endpoint pubblici e sulle API interne.

- Errore comune: Un errore frequente è terminare TLS al bordo della rete (ad es., un load balancer) e permettere traffico non cifrato all’interno della rete “fidata” interna. Questo crea una vulnerabilità significativa se un attaccante ottiene un punto d’appoggio interno.

Crittografia a riposo protegge i dati memorizzati in database, object storage o su supporti di backup.

- Best Practice: Utilizzare la transparent data encryption (TDE) offerta dalla maggior parte dei database moderni (ad es., PostgreSQL, MySQL). Per dati altamente sensibili, implementare la crittografia a livello applicativo, dove i dati sono crittografati prima di essere scritti nel database.

- Gestione delle chiavi: La sicurezza della crittografia dipende interamente dalla gestione delle chiavi. Usare un servizio dedicato di gestione chiavi (KMS) come AWS KMS o HashiCorp Vault. Non inserire mai chiavi di crittografia nel codice dell’applicazione o nei file di configurazione.

Per indicazioni sulla strutturazione di servizi interni sicuri, vedi la nostra guida sulla Service-Oriented Architecture.

Consenso robusto e controllo degli accessi

Un’architettura deve essere in grado di far rispettare le promesse di privacy fatte agli utenti. Ciò richiede due componenti chiave: un sistema robusto di gestione del consenso e controlli di accesso granulari basati sul principio del minimo privilegio.

Una Consent Management Platform (CMP) è più di un banner per i cookie. Architettonicamente, è un servizio centrale che registra le scelte degli utenti per distinte attività di trattamento dei dati (ad es., marketing, analytics). Tutti gli altri servizi nel sistema devono interrogare il CMP prima di eseguire un’azione rilevante.

Il Role-Based Access Control (RBAC) è il modello standard per applicare il principio del minimo privilegio. Assicura che utenti e sistemi possano accedere solo ai dati e compiere le azioni essenziali per la loro funzione.

- Implementazione: Definire ruoli chiari con permessi specifici e minimi (ad es.,

support_agent,billing_admin,user). - Granularità: Evitare ruoli eccessivamente ampi. Un support agent potrebbe aver bisogno di visualizzare la cronologia ticket di un cliente ma non dovrebbe poter accedere ai dettagli di pagamento a meno che non sia critico per un’attività specifica e auditata. L’architettura deve supportare questo livello di controllo granulare.

Sfide sulla privacy nei sistemi di IA

L’intelligenza artificiale e il machine learning introducono una nuova classe di rischi per la privacy che le pratiche tradizionali di ingegneria del software non affrontano pienamente. I Large Language Models (LLM) non sono semplici database; apprendono, inferiscono e possono memorizzare informazioni sensibili in modi difficili da prevedere o controllare.

Applicare la protezione della privacy fin dalla progettazione all’IA richiede un approccio specializzato.

Sebbene i metodi standard di protezione dei dati siano necessari, i sistemi di IA richiedono ulteriori livelli di scrutinio. La natura dell’addestramento e dell’inferenza dei modelli crea vulnerabilità uniche, dalla contaminazione dei dati di addestramento a modelli che involontariamente perdono informazioni personali.

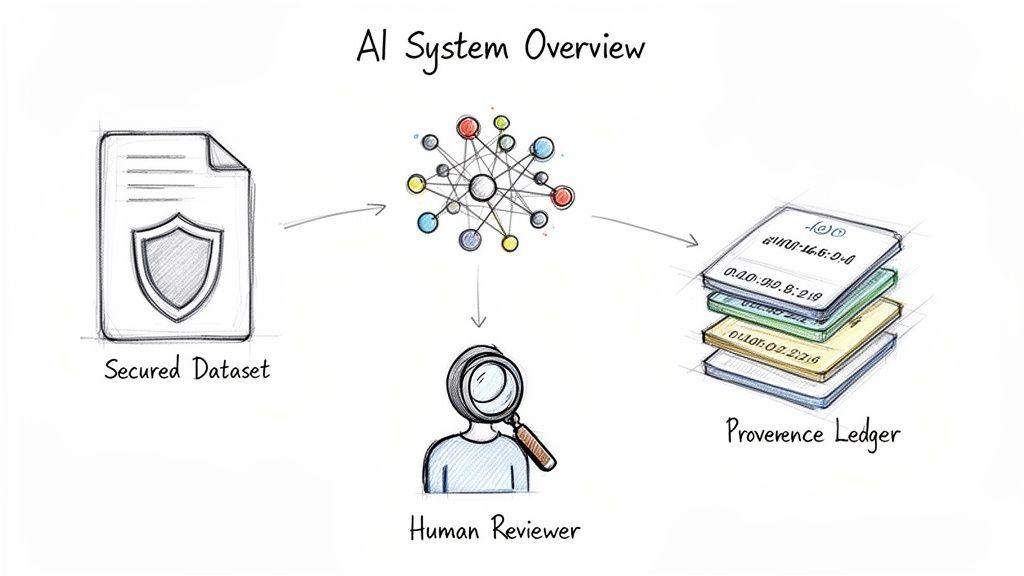

Provenienza dei dati e sicurezza dei dati di addestramento

L’integrità di un sistema di IA dipende dai suoi dati di addestramento. Senza un registro verificabile dell’origine dei dati, della loro liceità e delle trasformazioni subite, il sistema è costruito su una base instabile. La provenienza dei dati è la disciplina che mantiene un log dettagliato e verificabile del ciclo di vita di un dataset.

Questo non è un mero esercizio di conformità, ma una mitigazione per rischi tecnici seri. Ad esempio, un modello addestrato su dati ottenuti in modo improprio può essere vulnerabile ad attacchi di inversione del modello, in cui un avversario interroga il modello per ricostruire informazioni sensibili dal set di addestramento.

Una solida base di dati richiede:

- Audit di approvvigionamento etico: Verificare che i dati siano stati raccolti con il consenso appropriato e per uno scopo legittimo.

- Ledger immutabili: Usare tecnologie come blockchain o object storage versionato per creare un record immodificabile del ciclo di vita dei dati.

- Controlli di accesso rigorosi: Applicare il principio del minimo privilegio ai dataset di addestramento, limitando l’accesso al personale e ai sistemi autorizzati.

Senza una forte provenienza, è impossibile rispondere a domande fondamentali sul comportamento o sui bias di un modello, creando rischi legali e reputazionali significativi.

Rischi per la privacy negli embeddings e negli LLM

Un rischio sottile ma serio nell’IA moderna risiede nei modelli stessi. Gli LLM possono memorizzare e riprodurre involontariamente informazioni personali identificabili (PII) incontrate durante l’addestramento. Una query apparentemente innocua potrebbe indurre il modello a rivelare un nome, un indirizzo o altri dati privati.

Questo rischio è amplificato dagli embeddings — i vettori numerici che i modelli usano per rappresentare i dati. Questi vettori possono codificare involontariamente attributi sensibili, creando una porta posteriore per la ri-identificazione anche se i dati grezzi erano stati sanificati.

Un modello non ha bisogno di memorizzare un indirizzo email esatto per violare la privacy. Se le sue rappresentazioni interne (embeddings) raggruppano individui in base ad attributi sensibili dedotti, come lo stato di salute o difficoltà finanziarie, il potenziale di uso improprio è enorme. Qui la protezione della privacy fin dalla progettazione per l’IA diventa critica.

Mitigare questi rischi richiede una difesa a più livelli:

- Sanitizzazione aggressiva dei dati: Prima dell’addestramento, ripulire rigorosamente i dataset da tutte le PII dirette e indirette. Questo include nomi, indirizzi e qualsiasi identificatore unico che potrebbe essere combinato per la ri-identificazione.

- Filtraggio dell’output e protezioni: Implementare uno strato tra l’LLM e l’utente che scansioni gli output del modello alla ricerca di PII prima che vengano mostrati.

- Privacy differenziale nell’addestramento: Per applicazioni ad alto rischio, impiegare tecniche di privacy differenziale. Queste aggiungono rumore statistico durante l’addestramento per rendere matematicamente infattibile che il modello memorizzi punti dati individuali.

Un approccio strutturato è essenziale per i team che costruiscono prodotti AI. Usa il nostro AI Risk & Privacy Checklist gratuito per valutare l’architettura del tuo sistema e identificare vulnerabilità specifiche.

Governance Human-in-the-Loop

Per applicazioni AI ad alto impatto, l’automazione completa può rappresentare un rischio inaccettabile. Quando un’IA prende decisioni con impatto significativo sulle persone — in ambito finanziario, sanitario o legale — un’architettura Human-in-the-Loop (HITL) è essenziale per sicurezza, responsabilità e fiducia.

HITL è un pattern architetturale deliberato in cui il sistema è progettato per deferire al giudizio umano in punti critici. Questo fornisce una salvaguardia vitale contro errori del modello e conseguenze indesiderate.

Architettonicamente, l’implementazione di HITL comporta workflow specifici:

- Soglie di confidenza: Il modello elabora una richiesta e calcola un punteggio di confidenza. Se il punteggio è al di sotto di una soglia predefinita, il caso viene automaticamente segnalato per revisione umana.

- Code di revisione: I casi segnalati vengono instradati a un’interfaccia dedicata dove un esperto umano può rivedere l’input del modello, l’output proposto e il contesto rilevante.

- Loop di feedback: La decisione dell’esperto — approvazione, rifiuto o modifica — viene registrata e reinserita nel sistema come dato di addestramento per migliorare il modello nel tempo.

Questo approccio integra la governance direttamente nella funzionalità del sistema, trasformando un documento di policy in un processo operativo e vivente.

Stabilire la governance e misurare il successo

I pattern architetturali e le integrazioni nel ciclo di vita sono il motore della protezione della privacy fin dalla progettazione, ma la governance fornisce la direzione. Senza una chiara responsabilità e metriche, anche le migliori implementazioni tecniche possono fallire. Una privacy sostenibile richiede un cambiamento culturale supportato da responsabilità chiare e verifiche continue.

Questo framework sposta la privacy da una serie di compiti isolati a una disciplina operativa centrale, garantendo che la responsabilità sia distribuita all’interno dell’organizzazione.

Definizione dei ruoli e delle responsabilità

La proprietà ambigua è una modalità di fallimento comune. Quando tutti sono responsabili della privacy, nessuno lo è. Un programma duraturo richiede definizioni di ruolo chiare.

- Responsabile della protezione dei dati (DPO) o Responsabile Privacy: Questo ruolo funge da hub strategico, facilità il processo, fornisce consulenza esperta e agisce come contatto principale per i regolatori. Per molte organizzazioni questo può essere un ruolo frazionale o esterno.

- Privacy Champions: Sono ingegneri e product manager all’interno dei team di sviluppo che ricevono formazione aggiuntiva. Servono come prima linea di difesa, identificando potenziali problemi di privacy precocemente e promuovendo le migliori pratiche nelle operazioni quotidiane.

- Leadership di Prodotto e Ingegneristica: Il CTO e i responsabili di prodotto sono in ultima istanza responsabili. Devono allocare il budget, applicare paletti di privacy nelle approvazioni dei progetti e promuovere il business case per una solida postura sulla privacy. È essenziale un quadro di responsabilità chiaro, come dettagliato nella nostra practical guide to creating a code of conduct for engineering teams.

Verifica Continua tramite Audit e Checklist

La governance deve essere un processo attivo e continuo. Sono necessari meccanismi per garantire che i principi di privacy vengano applicati nella pratica.

Una Checklist di Rischio e Privacy integrata in uno strumento di gestione progetti (es. Jira, Asana) è una soluzione pragmatica. Prima che una nuova funzionalità possa essere marcata come “pronta per lo sviluppo”, il responsabile di prodotto deve completare la checklist, rispondendo a domande come:

- Quali nuovi dati personali raccoglie questa funzionalità?

- È stata condotta una Valutazione d’Impatto sulla Protezione dei Dati (DPIA)?

- Come viene applicata la minimizzazione dei dati?

- I nuovi flussi di dati sono documentati e approvati?

Questa soglia impone una conversazione deliberata sulla privacy prima che il codice venga scritto. Dovrebbe essere affiancata da audit regolari sulla privacy—combinando la scansione automatizzata del codice per vulnerabilità come i segreti hardcoded con revisioni manuali delle configurazioni di controllo degli accessi.

Lo scopo della governance non è creare burocrazia ma introdurre frizione produttiva. Costringe a una pausa deliberata per considerare le implicazioni sulla privacy prima che diventino esponenzialmente più costose da risolvere.

Misurare ciò che Conta

Per dimostrare valore e favorire il miglioramento, un programma di privacy deve essere misurato. La leadership richiede dati che dimostrino un ritorno sull’investimento.

I dati evidenziano la posta in gioco: il 71% dei consumatori riferisce che smetterebbe di avere rapporti commerciali con un’azienda se condividesse dati sensibili senza autorizzazione. I regolatori hanno inflitto oltre 4 miliardi di dollari in sanzioni GDPR negli ultimi tre anni, trattando le violazioni come gravi fallimenti aziendali.

Le metriche chiave da monitorare includono:

- Riduzione degli Incidenti di Privacy: Monitorare il numero di bug o vulnerabilità legate alla privacy segnalate su base trimestrale.

- Tempo di Risposta alle Richieste degli Interessati (DSR): Tracciare il tempo medio necessario per soddisfare richieste di accesso o cancellazione dei dati. Una media in diminuzione indica guadagni di efficienza nei processi.

- Tasso di Completamento delle Valutazioni d’Impatto sulla Privacy (PIA): Misurare la percentuale di nuovi progetti che completano una Valutazione d’Impatto sulla Privacy prima dell’inizio dello sviluppo. Questa metrica valuta l’aderenza al processo.

Queste metriche trasformano la privacy da ideale astratto a componente misurabile dell’eccellenza operativa, dimostrandone il valore per l’intera azienda.

Domande Comuni su Privacy by Design

Anche con una strategia chiara, sorgono domande pratiche. Ecco le questioni comuni poste da founder, CTO e responsabili di prodotto che adottano un modello privacy-first.

Non è Solo Conformità al GDPR?

No. La conformità al GDPR è un obiettivo normativo, spesso affrontato in modo reattivo. Privacy by Design è una filosofia ingegneristica proattiva che integra la protezione dei dati nel cuore dei vostri sistemi fin dall’inizio.

Sebbene PbD sia un componente chiave del GDPR (codificato nell’articolo 25), il suo scopo è più ampio: creare sistemi fondamentalmente affidabili e resilienti, non meramente conformi. Un sistema conforme può comunque avere debolezze architetturali; un sistema costruito con Privacy by Design è intrinsecamente più robusto.

È troppo costoso per una startup?

L’investimento iniziale in pianificazione e architettura è notevolmente meno costoso del costo a lungo termine dell’inazione. Tentare di retrofitare i controlli sulla privacy in un prodotto già in produzione è esponenzialmente più costoso e complesso rispetto a costruirli fin dall’inizio.

Un approccio ingenuo crea debito tecnico, interruzioni operative e potenziali violazioni dei dati, con costi che superano di gran lunga l’investimento iniziale. Per una startup, costruire su una base privata è un vantaggio competitivo che favorisce la fiducia dei clienti ed evita multe catastrofiche o danni reputazionali.

Il costo di un singolo progetto urgente di refactoring per correggere una falla di privacy post-lancio supererà quasi certamente il costo della pianificazione iniziale.

Questo rallenterà la nostra velocità di sviluppo?

Questa è una preoccupazione comune per i team agili. All’inizio, adottare pratiche come le Valutazioni d’Impatto sulla Privacy (PIA) e il threat modeling richiede un cambio di mentalità e può aggiungere tempo alla fase di discovery.

Tuttavia, una volta che queste pratiche diventano routinarie, cessano di essere un collo di bottiglia. Sul lungo periodo, spesso aumentano la velocità riducendo bug legati alla sicurezza, patch d’emergenza e il refactoring complesso che blocca lo sviluppo. L’approccio anticipa il pensiero critico per prevenire costosi rifacimenti successivi.

Qual è il primo passo pratico che possiamo intraprendere?

Iniziate dalla minimizzazione dei dati. È l’azione iniziale più semplice ed efficace.

Prima della vostra prossima sessione di pianificazione dello sprint, mettete in discussione ogni nuovo dato che intendete raccogliere. Chiedete al team: “Abbiamo davvero bisogno di questi dati affinché la funzionalità funzioni adesso?”

Questa singola domanda forza una conversazione critica e inizia a costruire le abitudini corrette. Non richiede nuovi strumenti o cambiamenti di processo importanti ma riduce immediatamente la superficie di rischio. È il punto di partenza a maggior leva e a più basso costo disponibile.

Costruire software sicuro, privato e manutenibile è al centro di ciò che facciamo. In Devisia, traduciamo la vostra visione di business in prodotti digitali e sistemi di IA affidabili, con la privacy come scelta architetturale, non come ripensamento. Scoprite di più sul nostro approccio pragmatico allo sviluppo software su misura.