Una pipeline CI/CD è il processo automatizzato che sposta il software dal commit di uno sviluppatore attraverso le fasi di build, test e deployment in un ambiente di produzione. Funziona come un piano di controllo centrale per la consegna del software, applicando qualità e coerenza ed eliminando i rischi insiti nell’intervento manuale. Per qualsiasi organizzazione che costruisca o gestisca sistemi software reali, una pipeline robusta non è un lusso — è un requisito fondamentale per release prevedibili e di alta qualità.

Il problema: Perché la consegna manuale è insostenibile

In un mercato competitivo, la velocità e l’affidabilità della consegna del software sono fattori diretti dei risultati di business. I processi di deployment manuale introducono un’attrito significativo, causando ritardi inaccettabili e una alta probabilità di errore umano. Ogni passaggio manuale — compilare il codice, eseguire i test, configurare gli ambienti o distribuire gli artifact — diventa un potenziale punto di guasto.

Questo attrito crea problemi sistemici:

- Cicli di rilascio imprevedibili: I processi manuali sono intrinsecamente incoerenti, rendendo difficile prevedere quando le nuove funzionalità raggiungeranno gli utenti.

- Aumento del rischio: I deployment “big bang”, che raggruppano numerose modifiche, amplificano il rischio associato a ogni release. Un singolo errore può causare downtime significativo e richiedere rollback complessi e stressanti.

- Feedback ritardato: Gli sviluppatori potrebbero non scoprire che le loro modifiche hanno rotto il sistema fino a giorni o settimane dopo il commit iniziale, rendendo il debugging costoso e inefficiente.

- Freno all’innovazione: Quando i deployment sono percepiti come eventi ad alto rischio, i team diventano riluttanti a rilasciare frequentemente. Questa cautela soffoca l’innovazione e allarga il divario tra sviluppo del prodotto e esigenze del mercato.

Per le organizzazioni che operano in settori regolamentati o gestiscono sistemi AI complessi, le conseguenze di un deployment fallito vanno oltre i problemi tecnici, impattando la fiducia dei clienti, la conformità normativa (es. GDPR, DORA) e la stabilità finanziaria.

La soluzione: Un cambiamento strategico verso l’automazione

Una pipeline CI/CD affronta questi problemi trasformando la consegna del software da un evento manuale ad alto rischio in un flusso di lavoro automatizzato a basso rischio. Automatizzando sistematicamente le fasi di build, test e deployment, stabilisce un percorso coerente, ripetibile e verificabile dal codice sorgente alla produzione.

Questa scelta architetturale offre vantaggi critici:

- Cicli di feedback accelerati: La pipeline fornisce feedback immediato. Se un commit introduce una regressione o non supera una scansione di sicurezza, lo sviluppatore viene avvisato entro minuti, non giorni.

- Consegna incrementale e a basso rischio: L’automazione permette ai team di rilasciare piccole modifiche incrementali. Questa pratica riduce drasticamente il raggio d’impatto potenziale dei guasti e semplifica la risoluzione dei problemi.

- Maggiore affidabilità e conformità: L’automazione elimina la deriva di configurazione e le procedure manuali incoerenti. Ogni deployment aderisce allo stesso processo validato, garantendo affidabilità e fornendo una chiara traccia di audit per scopi di conformità.

I dati di mercato sottolineano questo cambiamento strategico. Il mercato degli strumenti di integrazione continua era valutato $1,73 miliardi nel 2025 e dovrebbe raggiungere $4,53 miliardi entro il 2030. Questo non è un fenomeno superficiale; è un chiaro indicatore che le organizzazioni stanno investendo nell’automazione come capacità fondamentale. I team maturi rilasciano software dal 60% all’80% più velocemente rispetto a quelli che si affidano ancora a processi manuali. Puoi trovare ulteriori dati sull’adozione degli strumenti CI/CD su TechnologyMatch.com.

Una pipeline CI/CD non è semplicemente un insieme di strumenti; è un asset strategico. Permette a un’azienda di rispondere ai cambiamenti del mercato con agilità, innovare con fiducia e costruire sistemi resilienti che supportino la stabilità operativa a lungo termine.

Decostruire una pipeline CI/CD pronta per la produzione

Una pipeline CI/CD pronta per la produzione è più di una sequenza di script; è una catena di montaggio automatizzata progettata per trasformare i commit del codice sorgente in release validate e di livello produzione. Ogni fase funziona come un cancello di qualità, assicurando che solo codice affidabile proceda al passaggio successivo.

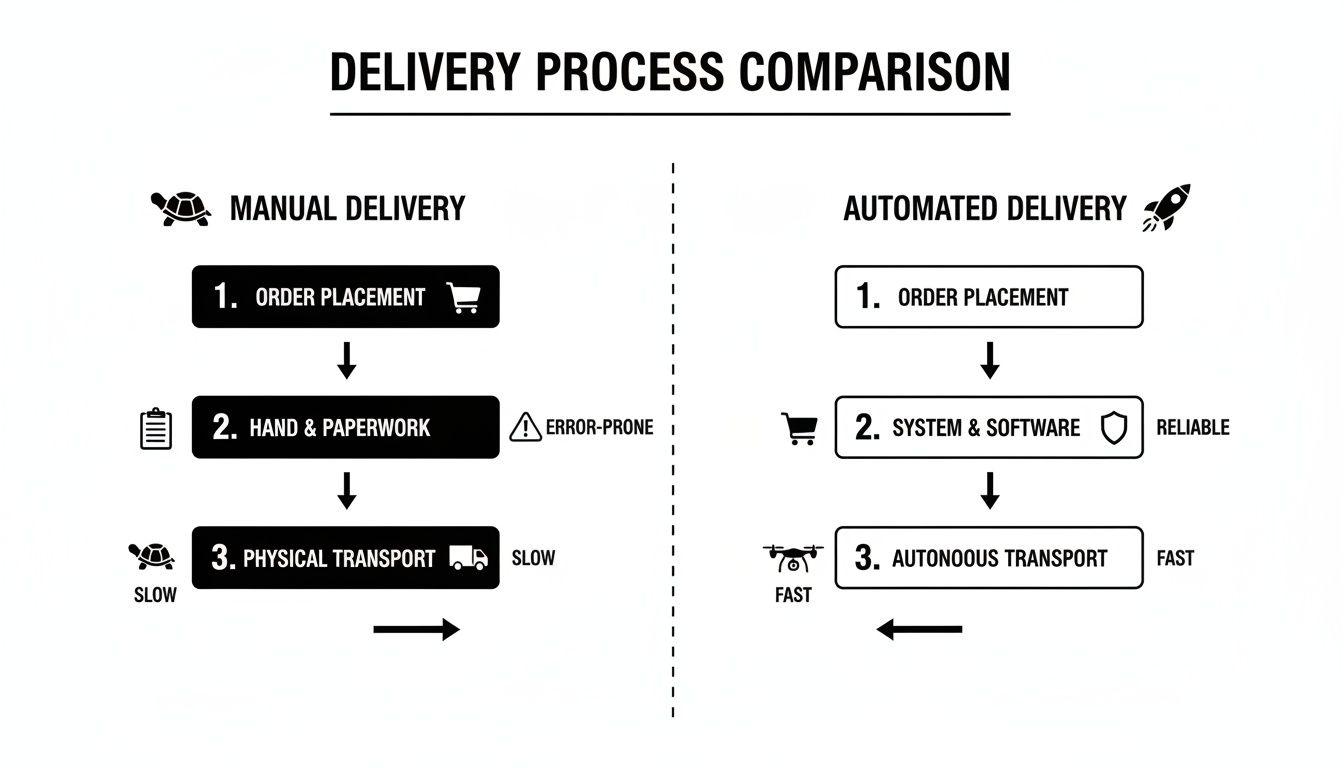

Questa infografica illustra il contrasto tra la natura lenta e soggetta a errori della consegna manuale e l’output prevedibile e ad alta velocità di una pipeline automatizzata ben progettata.

Il principio fondamentale è la sostituzione di azioni umane incoerenti con processi deterministici e automatizzati. Questo migliora direttamente sia la velocità di consegna sia la qualità del software. Per implementare un tale sistema, dobbiamo prima comprendere le sue fasi costitutive.

Fasi chiave di una pipeline CI/CD e loro funzioni principali

La tabella seguente delinea le fasi principali di una pipeline tipica. Ogni fase si basa su quella precedente, spostando metodicamente il codice dal commit alla produzione attraverso una serie di controlli di qualità automatizzati.

| Fase | Obiettivo principale | Attività comuni | Considerazioni di implementazione |

|---|---|---|---|

| Source | Innescare la pipeline e applicare la qualità del codice al punto di ingresso. | Commit del codice in un repository Git, trigger via webhook, revisioni del codice obbligatorie, branch protetti. | Stabilisce una singola fonte di verità e impedisce che codice non verificato entri nel ramo principale di sviluppo. |

| Build | Compilare il codice sorgente in un pacchetto eseguibile e autonomo (artefatto). | Compilazione del codice, esecuzione di linter, risoluzione delle dipendenze, creazione di un’immagine container Docker. | Crea un artefatto consistente e portabile che si comporta in modo identico in tutti gli ambienti. |

| Test | Validare automaticamente l’artefatto in termini di correttezza, prestazioni e sicurezza. | Esecuzione di test unitari, di integrazione e end-to-end; analisi statica (SAST); scansione delle vulnerabilità delle dipendenze. | Individua i difetti precocemente, riduce il carico del QA manuale e costruisce fiducia nel candidato alla release. |

| Deploy | Rilasciare l’artefatto validato in uno o più ambienti. | Push dell’artefatto in staging o produzione usando strategie come blue-green, canary o rolling deployments. | Consente la consegna rapida di nuove funzionalità agli utenti con rischio minimo e permette la raccolta controllata del feedback. |

Un fallimento in qualsiasi fase arresta il processo e fornisce feedback immediato al team di sviluppo, garantendo che i problemi siano risolti prima di raggiungere gli utenti.

La fase Source: il punto unico di ingresso

L’intera pipeline viene innescata quando uno sviluppatore esegue un commit in un sistema di controllo di versione (VCS) come Git. Il VCS non è semplicemente un meccanismo di archiviazione; è la fonte di verità autoritativa e verificabile per l’intero sistema.

A questa fase, l’integrità del processo è fondamentale. Applicare pratiche come branch protetti e revisioni obbligatorie tra pari serve come prima linea di difesa, assicurando che gli standard di qualità del codice siano rispettati prima che inizi l’automazione. Questo è il controllo di qualità applicato alla fonte.

La fase Build: dal codice all’artefatto

Dopo un commit riuscito su un ramo designato, il server di Integrazione Continua (CI) (ad es. Jenkins, GitLab CI) recupera il codice sorgente più recente e avvia il processo di build. L’obiettivo è compilare il codice e impacchettarlo in un’unica unità immutabile e distribuibile nota come artefatto.

Nelle architetture moderne, questo artefatto è tipicamente un’immagine container Docker. La containerizzazione è una scelta architetturale critica perché incapsula l’applicazione insieme a tutte le sue dipendenze — librerie, runtime e file di configurazione — in un pacchetto isolato. Questo garantisce che l’applicazione venga eseguita in modo coerente in tutti gli ambienti, eliminando la classe di problemi del tipo “funziona sulla mia macchina”.

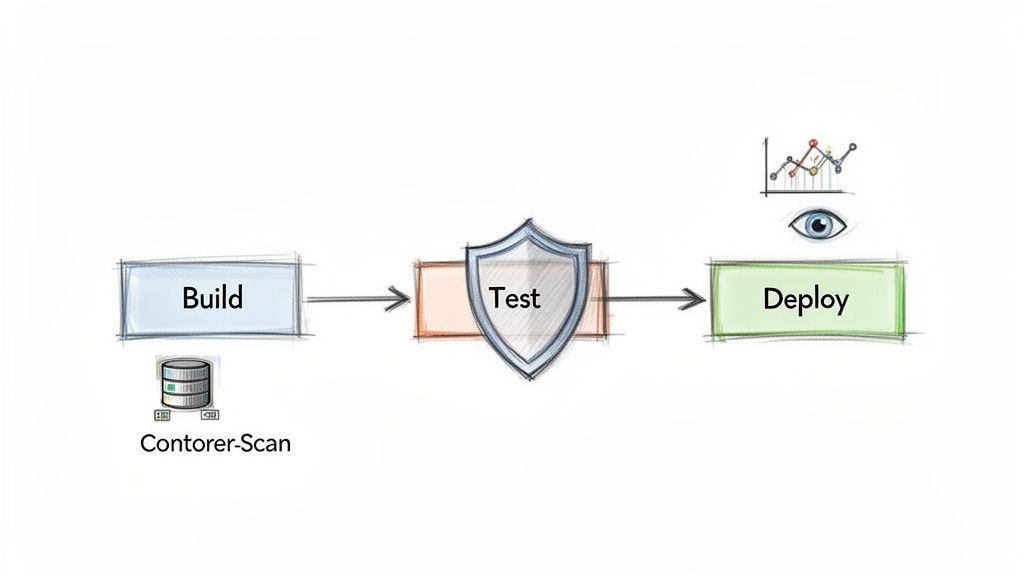

La fase Test: validazione automatizzata

Con un artefatto di build disponibile, la pipeline procede con i test automatizzati. Questa non è un’unica prova ma una strategia di validazione multilivello progettata per rilevare i difetti il prima possibile, quando sono più economici da correggere. Un errore comune nell’implementazione è fare affidamento su un solo tipo di test. Una pipeline robusta bilancia velocità e copertura con una combinazione di tipi di test:

- Test unitari: Test veloci che verificano componenti o funzioni individuali in isolamento. Forniscono feedback immediato agli sviluppatori ma non convalidano le interazioni tra componenti.

- Test di integrazione: Test più lenti che verificano le interazioni tra diverse parti del sistema (es. applicazione e database).

- Test end-to-end (E2E): I test più completi, che simulano i flussi reali degli utenti dall’inizio alla fine. Offrono la massima fiducia ma sono i più lenti e fragili da mantenere.

Il compromesso è chiaro: test più veloci e mirati forniscono feedback rapido, mentre test più lenti e ampi offrono maggiore fiducia. Una pipeline efficace esegue questi test in modo strategico, iniziando dai più veloci (test unitari) per far “fallire rapidamente” prima di investire tempo in una validazione più completa.

La fase Deploy: rilascio controllato in produzione

Una volta che un artefatto supera tutti i test automatizzati, è pronto per il deployment. Questa fase di Continuous Delivery (CD) rilascia la build validata agli utenti. Una pipeline matura considera il deployment come un processo controllato e strategico, non come un evento ad alto rischio.

Una pipeline CI/CD matura rende il deployment un’operazione di routine e a basso rischio. L’obiettivo è rilasciare con fiducia minimizzando l’impatto potenziale di eventuali problemi imprevisti.

Le strategie moderne di deployment limitano il “raggio d’impatto” di una nuova release. Invece di un aggiornamento “big bang” ad alto rischio, i team utilizzano pattern come:

- Blue-Green Deployment: Il traffico viene commutato istantaneamente da una versione vecchia dell’applicazione a una nuova.

- Canary Releases: La nuova versione viene distribuita inizialmente a una piccola porzione di utenti. Se il monitoraggio indica stabilità, il rilascio viene gradualmente esteso all’intera base utenti. Questo approccio trasforma i rilasci da eventi stressanti in operazioni aziendali di routine.

Scegliere il giusto pattern architetturale per la tua pipeline

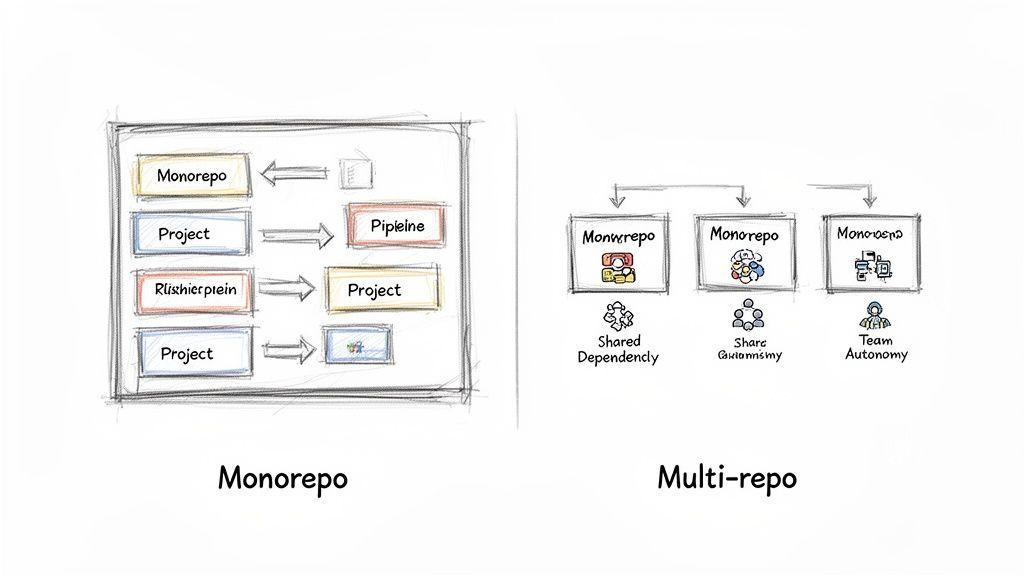

La scelta del pattern architetturale per il tuo sistema pipeline ci cd è una decisione fondamentale che impatta direttamente la produttività degli sviluppatori, le prestazioni di build e la manutenibilità a lungo termine. La scelta ruota attorno alla struttura del repository, che a sua volta determina come le pipeline sono organizzate, innescate e gestite. Non esiste una risposta universalmente corretta; la scelta ottimale dipende dalla struttura del team, dalla complessità del progetto e dagli obiettivi strategici.

I due pattern architetturali dominanti sono il monorepo e il multi-repo, ciascuno con compromessi distinti.

Monorepo: l’approccio centralizzato

Un monorepo consolida tutto il codice di un’organizzazione in un unico repository. Tutti i servizi, le applicazioni e le librerie condivise coesistono.

- Vantaggio chiave: Semplifica le modifiche trasversali e la gestione delle dipendenze. Le modifiche che interessano più servizi possono essere fatte in un singolo commit atomico, garantendo coerenza a livello di sistema. Esiste una sola versione di qualsiasi libreria condivisa, mitigando i problemi di “dependency hell”.

- Vincolo principale: Può soffrire di problemi di prestazioni man mano che il repository cresce. Senza strumenti intelligenti che costruiscano solo ciò che è cambiato, i tempi di build possono diventare proibitivamente lunghi. La semplice scala può anche presentare sfide sia per gli sviluppatori che per il sistema CI.

Multi-repo: il modello distribuito

In un’architettura multi-repo, ogni servizio o applicazione ha il proprio repository dedicato. Questo modello favorisce l’autonomia dei team, permettendo a ciascuno di gestire la propria codebase, le dipendenze e il ciclo di rilascio.

- Vantaggio principale: Le pipeline sono tipicamente più veloci e focalizzate, poiché sono circoscritte a un singolo servizio. I team possono operare in modo indipendente senza interferenze.

- Vincolo principale: Gestire le dipendenze e coordinare le modifiche tra più repository è una sfida significativa. L’aggiornamento di una libreria condivisa può innescare una cascata di cambiamenti in più servizi, richiedendo orchestrazione e versioning complessi. Questo sovraccarico operativo non va sottovalutato.

I dati del settore confermano l’adozione diffusa di queste pratiche. Oggi, l’83% dei decisori IT ha implementato pratiche DevOps. Il mercato degli strumenti riflette questo trend, con piattaforme come Atlassian Bitbucket che detengono una quota di mercato del 18.61% e CircleCI al 5.72%. I team maturi che sfruttano l’automazione delle pipeline si liberano del 33% di tempo in più per lavori infrastrutturali critici. Altre statistiche DevOps sono disponibili su Spacelift.io.

Pipelines-as-Code: una pratica imprescindibile

Indipendentemente dalla struttura dei repository, una pratica è essenziale: definire la pipeline usando Pipelines-as-Code. Questo implica il commit della definizione della pipeline — tipicamente un file YAML per strumenti come GitHub Actions o GitLab CI/CD — nello stesso repository del codice dell’applicazione.

Trattando la configurazione della pipeline come codice, la trasformi da un processo fragile e configurato manualmente in un asset versionato, verificabile e recuperabile. Questo è un principio fondamentale per costruire sistemi software resilienti e manutenibili.

Questo approccio offre benefici immediati:

- Controllo di versione: Tutte le modifiche alla pipeline sono tracciate in Git, fornendo una cronologia completa.

- Auditabilità: La definizione della pipeline viene revisionata e approvata tramite lo stesso processo di pull request usato per il codice applicativo.

- Riproducibilità: Un nuovo ambiente può essere provisionato o recuperato istantaneamente, poiché la definizione della pipeline è memorizzata nel controllo di versione.

La scelta tra monorepo e multi-repo è una decisione strategica basata sui compromessi organizzativi. Tuttavia, adottare Pipelines-as-Code è una necessità tattica per qualsiasi team che costruisca un processo di delivery robusto.

Integrare sicurezza e osservabilità nella pipeline

Una pipeline di base automatizza il rilascio, ma una moderna pipeline CI/CD costruisce fiducia e resilienza nel ciclo di vita del software. L’obiettivo non è semplicemente consegnare il codice più velocemente, ma consegnarlo in modo sicuro e con una chiara comprensione del suo comportamento in produzione. Questo richiede l’integrazione dei principi DevSecOps e dell’osservabilità direttamente nella pipeline, rendendoli proprietà intrinseche del processo di delivery, non ripensamenti.

Questa filosofia di “shift-left” comporta lo spostamento delle verifiche di sicurezza e qualità il più presto possibile nel ciclo di sviluppo. Invece di scoprire una vulnerabilità critica settimane dopo il deployment, l’obiettivo è rilevarla minuti dopo un commit. Questo approccio proattivo è essenziale per costruire sistemi sicuri e manutenibili.

Shift-left con scansioni di sicurezza integrate

Gli strumenti di sicurezza automatizzati integrati nella pipeline sono il modo più efficace per far rispettare le policy di sicurezza. Non si tratta di creare cancelli burocratici, ma di fornire agli sviluppatori feedback immediati e azionabili. Le revisioni di sicurezza manuali sono troppo lente e costose per essere la prima linea di difesa.

Una pipeline DevSecOps robusta include diversi livelli di scansione automatizzata:

- Static Application Security Testing (SAST): Scansiona il codice sorgente alla ricerca di vulnerabilità note (es. SQL injection, gestione degli errori insicura) prima della compilazione.

- Dependency Scanning: Controlla tutte le librerie di terze parti rispetto a database di vulnerabilità note (CVE), segnalando ogni pacchetto che introduce rischio.

- Container Analysis: Scansiona le immagini container di Docker alla ricerca di vulnerabilità nel sistema operativo di base o nei pacchetti installati e di errori di configurazione di sicurezza.

Integrando questi controlli, si stabilisce una baseline di sicurezza rispetto alla quale ogni commit viene valutato. Questo non è solo una best practice tecnica; è una strategia critica di gestione del rischio. Puoi iniziare identificando i potenziali punti deboli con la nostra gratuita Checklist AI per Rischi & Privacy.

Trattare la pipeline come un prodotto

Una pipeline CI/CD è un prodotto interno i cui clienti sono i tuoi team di ingegneria. Come qualsiasi prodotto, richiede manutenzione, monitoraggio e miglioramento continuo. Questo implica costruire l’osservabilità nella stessa pipeline.

Una pipeline senza metriche è una scatola nera. Non puoi migliorare ciò che non misuri. L’obiettivo è raccogliere dati azionabili che aiutino a identificare i colli di bottiglia e aumentare la produttività degli sviluppatori.

Le metriche chiave da monitorare includono:

- Durata del build: Quanto tempo impiega una run della pipeline dal commit al completamento? Picchi possono indicare test inefficienti o vincoli di risorse.

- Tasso di fallimento: Quale percentuale delle run della pipeline fallisce? Un tasso di fallimento elevato spesso indica test “flaky” che erodono la fiducia degli sviluppatori nell’automazione.

- Tempo di recupero: Quando una pipeline si rompe, quanto tempo serve per riportarla in uno stato funzionante? Questa metrica riflette la manutenibilità del sistema.

L’analisi di queste metriche aiuta a identificare i punti di attrito. I dati mostrano che le organizzazioni mature spesso utilizzano più strumenti CI/CD (il 32% ne usa due, il 9% ne usa tre o più), con GitHub Actions in testa con un’adozione del 33% e Azure DevOps al 24%. Questo riflette una strategia di selezione di strumenti best-in-class per esigenze specifiche come sicurezza e osservabilità. Il ROI è significativo, con il 44% dei leader che segnala un ritorno di 5x e un risparmio superiore a 2,5 milioni di dollari in tre anni rilevando i problemi prima. Ulteriori statistiche CI/CD possono essere trovate su Integrate.io.

Questa mentalità di prodotto — affinare continuamente la pipeline basandosi sui dati — è ciò che distingue un semplice script di automazione da un asset strategico che moltiplica l’efficacia dell’ingegneria.

Evitare errori comuni e anti-pattern della pipeline

Implementare una pipeline CI/CD è un miglioramento architetturale significativo, ma l’automazione da sola non garantisce il successo. Senza un’attenta progettazione e manutenzione, una nuova toolchain può diventare fonte di attrito e di guasti. Questi problemi, o anti-pattern, sorgono tipicamente non per limiti tecnici ma per la negligenza nel considerare la pipeline come un sistema vivente che richiede miglioramento continuo.

La pipeline “flaky”

Una “flaky pipeline” è una pipeline che fallisce per ragioni non deterministiche non correlate alla modifica del codice, come timeout di rete, problemi transitori dell’ambiente o test scritti male. Questo è altamente corrosivo per il morale del team.

Quando gli sviluppatori non possono più fidarsi di un build rosso per indicare un problema reale, iniziano a ignorare tutti i fallimenti del build. L’automazione diventa rumore e il suo valore viene perso. Lo standard deve essere la affidabilità al 100%: la pipeline fallisce solo quando c’è un problema genuino da risolvere. Ciò richiede di identificare e mettere in quarantena test non deterministici.

Cicli di feedback lenti

Una pipeline che impiega un’ora per fornire feedback è un grande assassino di produttività. I lunghi cicli di build e test costringono gli sviluppatori a cambiare contesto, interrompendo il loro flusso di lavoro e rallentando lo slancio del team. Inoltre, lunghi feedback loop aumentano la probabilità che si accumulino cambiamenti conflittuali nel branch principale, complicando l’integrazione.

È necessaria un’ottimizzazione costante:

- Parallelizzare l’esecuzione dei test: Eseguire suite di test indipendenti in parallelo per ridurre il tempo totale.

- Ottimizzare la cache del build: Configurare il processo di build per riutilizzare artefatti compilati e dipendenze precedenti.

- Fallire velocemente: Strutturare la pipeline per eseguire prima i test più rapidi (es. linters, unit test) per fornire feedback immediati su errori semplici.

Il collo di bottiglia nel deployment

Questo anti-pattern è spesso culturale più che tecnico. Si verifica quando l’automazione è implementata fino al punto del deployment, ma il rilascio finale in produzione è bloccato da cancelli di approvazione manuale, riunioni di change advisory board o da una cultura della paura attorno alle release.

Una pipeline è veloce quanto il suo cancello più restrittivo. Se l’automazione termina a un board di approvazione manuale, hai raggiunto l’integrazione continua ma sei ancora lontano dalla delivery continua.

La soluzione consiste nel costruire fiducia nell’automazione. Implementa rollout progressivi come canary release, investi in robusta osservabilità per monitorare le prestazioni in tempo reale e responsabilizza i team con l’autonomia di distribuire i propri servizi. Questo è un aspetto centrale del miglioramento continuo, un argomento che esploriamo nella nostra guida su come i progetti Kaizen mantengono i sistemi esistenti.

Gestione inadeguata dei segreti

Hardcodare segreti — chiavi API, credenziali del database, certificati — direttamente negli script della pipeline o nel controllo di versione è una grave vulnerabilità di sicurezza. Espone credenziali critiche a chiunque abbia accesso al repository o ai log di build.

Questo è non negoziabile: una pipeline deve integrarsi con uno strumento dedicato per la gestione dei segreti come HashiCorp Vault, AWS Secrets Manager o Azure Key Vault. Le credenziali dovrebbero essere iniettate dinamicamente nell’ambiente di build a runtime e non devono mai essere memorizzate in testo semplice.

Anti-pattern della pipeline CI/CD e strategie di mitigazione

| Anti-pattern | Impatto negativo | Strategia di mitigazione raccomandata |

|---|---|---|

| La pipeline “flaky” | Gli sviluppatori perdono fiducia nei risultati dei build e iniziano a ignorare i fallimenti, rendendo la pipeline inutile. | Identificare e mettere in quarantena i test non deterministici in modo aggressivo. Mirare a un build affidabile al 100%. |

| Cicli di feedback lenti | Gli sviluppatori cambiano contesto, la produttività cala e l’integrazione diventa più complessa e rischiosa. | Parallelizzare i test, ottimizzare la cache e strutturare la pipeline per “fallire velocemente” eseguendo prima i test rapidi. |

| Il collo di bottiglia del deployment | Il valore dell’automazione si perde a causa di cancelli manuali e di una cultura guidata dalla paura, impedendo la vera delivery continua. | Costruire fiducia tramite osservabilità, adottare rollout progressivi (es. canary releases) e responsabilizzare i team. |

| Gestione inadeguata dei segreti | Espone credenziali sensibili nel codice o nei log, creando una grave vulnerabilità di sicurezza. | Integrare un gestore di segreti dedicato per iniettare credenziali dinamicamente a runtime. Mai hardcodare i segreti. |

Evitare questi problemi richiede di considerare la pipeline non solo come uno strumento tecnico, ma come un processo critico che richiede disciplina, manutenzione e miglioramento continuo.

Principi essenziali per un’implementazione CI/CD di successo

Una implementazione di CI/CD di successo è più di un esercizio tecnico; è un’iniziativa strategica che richiede un cambiamento nella cultura e nelle pratiche ingegneristiche. Aderire a pochi principi fondamentali garantisce che la pipeline offra valore aziendale tangibile invece di diventare un ulteriore strato di complessità.

Iniziare dal problema, non dallo strumento

Prima di valutare gli strumenti CI/CD, definisci chiaramente il problema che stai risolvendo. Il problema principale sono cicli di rilascio lenti? Alte percentuali di fallimenti in produzione? Flussi di lavoro degli sviluppatori inefficaci? Una dichiarazione del problema ben definita assicura che la tua strategia pipeline CI/CD sia focalizzata sull’affrontare vincoli aziendali specifici, evitando l’adozione della tecnologia per il gusto di farlo.

Tratta la tua pipeline come un prodotto

La tua pipeline è un prodotto interno e i tuoi ingegneri sono i suoi clienti. Richiede una chiara ownership, una roadmap di manutenzione e un affinamento continuo basato sul feedback degli utenti. Misura le sue prestazioni, individua i colli di bottiglia e investi tempo di ingegneria per renderla più veloce, più affidabile e più facile da usare.

Una pipeline di cui gli sviluppatori non si fidano è peggiore di nessuna pipeline. Deve essere affidabile, efficiente e attivamente mantenuta per aggiungere valore. Altrimenti diventa solo un’altra fonte di frustrazione.

Integrare la sicurezza fin dal primo giorno

La sicurezza non può essere un ripensamento. Deve essere una parte automatizzata e integrante della pipeline fin dal primo commit. Integra strumenti per l’analisi statica (SAST), l’analisi della composizione del software (SCA) per le dipendenze e la scansione dei container direttamente nel flusso di lavoro. Questo approccio “shift-left” fornisce agli sviluppatori un feedback immediato sulla sicurezza e favorisce una cultura di responsabilità condivisa in materia di sicurezza.

Favorire una cultura di iterazione e fiducia

L’efficacia di una pipeline è in ultima analisi determinata dalla cultura organizzativa. L’automazione deve andare di pari passo con la sicurezza psicologica, consentendo ai team di distribuire modifiche piccole e frequenti senza paura di incolpare qualcuno. Ciò richiede l’implementazione di post-mortem senza colpe e la promozione di un senso di ownership operativa condivisa. Questo principio è una pietra miliare di una sana cultura ingegneristica, che dettagliamo nella nostra guida alla creazione di un codice di condotta per team di ingegneria e IA.

Domande frequenti

Qui trovi risposte pratiche alle domande comuni che emergono quando si pianifica o si affina una strategia pipeline CI/CD, pensate per guidare i leader tecnici.

Come scegliamo gli strumenti CI/CD giusti?

Lo “strumento migliore” è quello che si adatta meglio al tuo ecosistema tecnico, alla competenza del team e ai requisiti di scalabilità. L’obiettivo è ridurre l’attrito per gli sviluppatori, non adottare l’ultima tendenza.

Considera questi fattori:

- Integrazione con l’ecosistema: Se la tua organizzazione usa GitHub, GitHub Actions offre un’integrazione senza soluzione di continuità. Per chi cerca una piattaforma tutto-in-uno, GitLab combina controllo del sorgente, CI/CD e registry.

- Personalizzazione vs. Manutenzione: Per flussi di lavoro complessi e su misura, Jenkins offre ampia personalizzazione ma comporta un overhead di manutenzione maggiore.

- Allineamento con il provider cloud: I principali provider cloud—AWS, Azure e GCP—offrono servizi CI/CD maturi e nativi che si integrano strettamente con le rispettive offerte infrastrutturali.

Seleziona strumenti che si allineano e migliorano i flussi di lavoro esistenti.

Qual è la differenza tra Continuous Delivery e Continuous Deployment?

Questi termini descrivono due livelli distinti di automazione nel processo di rilascio. La distinzione è fondamentale per impostare obiettivi strategici chiari per la tua pipeline.

- Continuous Delivery garantisce che ogni cambiamento che supera tutti i test automatizzati venga automaticamente rilasciato in un ambiente di tipo staging. Tuttavia, il deployment finale in produzione richiede un’approvazione manuale. Questo modello offre controllo sul timing preciso dei rilasci.

- Continuous Deployment è l’automazione completa dell’intero processo di rilascio. Ogni cambiamento che supera tutti i test automatizzati viene distribuito automaticamente in produzione senza intervento umano. Questo richiede un livello estremamente alto di fiducia nei test, nel monitoraggio e nelle capacità di rollback automatico.

Come possiamo misurare il ROI di una pipeline CI/CD?

Il ritorno sull’investimento (ROI) di una pipeline CI/CD si misura attraverso metriche che riflettono miglioramenti tangibili nella performance di delivery, nella qualità e nell’efficienza ingegneristica. Le quattro principali metriche DORA sono lo standard del settore per misurare le prestazioni di un’organizzazione di delivery software:

- Frequenza di deployment: Quanto spesso un’organizzazione rilascia con successo in produzione.

- Lead time per le modifiche: Il tempo necessario perché un commit arrivi in produzione.

- Percentuale di fallimento delle modifiche: La percentuale di deployment che causano un errore in produzione.

- Tempo per ripristinare il servizio (MTTR): Quanto tempo ci vuole per recuperare da un guasto in produzione.

I miglioramenti in queste metriche forniscono una base quantitativa per il ROI, che può essere integrata con dati qualitativi come ore di sviluppo risparmiate da compiti manuali e costi evitati grazie alla riduzione degli incidenti in produzione.

Come si applica CI/CD ai modelli AI e ML?

I principi di una pipeline CI/CD sono fondamentali per le operazioni di Machine Learning (MLOps), ma vengono estesi per gestire il ciclo di vita unico dei modelli AI/ML. L’obiettivo rimane automazione e affidabilità, ma il processo deve gestire asset oltre al codice sorgente, nello specifico dati e modelli addestrati.

Una pipeline MLOps include le fasi CI standard ma ne aggiunge di nuove:

- Validazione dei dati: Controlli automatizzati sulla qualità, sullo schema e sulle proprietà statistiche dei dati di addestramento.

- Addestramento e validazione del modello: Riaddestramento automatizzato dei modelli e valutazione programmatica rispetto a benchmark di performance.

- Distribuzione del modello: Impacchettamento del modello validato come servizio scalabile o API.

- Monitoraggio in produzione: Monitoraggio continuo delle prestazioni reali del modello per rilevare il “concept drift” o il degrado dei dati che richiedono un riaddestramento.

MLOps adatta il paradigma CI/CD per gestire il ciclo di vita completo di dati, modelli e codice come un sistema coerente.

A Devisia crediamo che una pipeline CI/CD solida sia la base di qualsiasi prodotto digitale affidabile. Collaboriamo con le aziende per costruire sistemi software manutenibili e scalabili con una mentalità da prodotto che garantisce valore nel lungo termine. Scopri come possiamo aiutarti a trasformare la tua visione in realtà su https://www.devisia.pro.

Articolo creato usando Outrank